Anonymný pohyb na internete je častokrát spájaný s kriminálnou aktivitou a prezeraním nelegálneho obsahu. V spoločnosti prevláda názor, že anonymitu vyhľadávajú predovšetkým osoby pri páchaní trestnej činnosti alebo prehliadaní nelegálneho obsahu bez pocitu strachu. Realita je omnoho rozmanitejšia. Po anonymite siahajú aj jednotlivci, ktorým záleží na súkromí pri prehliadaní internetu, komunikácií so svetom či pri prenose a ochrane citlivých údajov. (Zachar, 2022)

Hoci internet môže na prvý pohľad pôsobiť ako bezpečný priestor, každým dňom narastá počet nových hrozieb, ktoré môžu súkromie a bezpečnosť užívateľov ohroziť. Zachar definuje koncept súkromia ako schopnosť kontrolovať distribúciu osobných informácií. (2022)

Snaha o väčšiu kontrolu nad vlastnými údajmi vedie mnohých používateľov k hľadaniu nástrojov na dosiahnutie anonymity. Jedným z najpopulárnejších spôsobov zlepšenia anonymity na internete je technológia VPN (Virtual Private Network). Tá umožňuje šifrovať internetové pripojenie, maskovať IP adresu používateľa a vytvárať zabezpečené spojenie. Rovnako dôležitou technológiou je Tor (The Onion Router), ktorý pomáha používateľom na celom svete udržať anonymitu prostredníctvom prepojenia dát cez viacero šifrovaných uzlov. Tento nástroj využívajú nielen vedci, dobrovoľníci, novinári či vládne inštitúcie, ale aj bežní užívatelia hľadajúci slobodu a bezpečie pri online komunikácii. S narastajúcim počtom kybernetických hrozieb, ako je krádež identity či páchanie trestných činov online, Tor pomáha chrániť základné práva na súkromie a anonymitu. (Mistata, 2013)

Napriek tomu, že VPN a Tor predstavujú kľúčové nástroje na zvýšenie anonymity na internete, obe majú určité obmedzenia znižujúce ich účinnosť. Obmedzenia môžu byť spôsobené nielen technickými faktormi ale aj legislatívnymi zásahmi.

1.1 Anonymný pohyb na internete

Anonymita nie je nový pojem. Vychádza z gréckeho „anonymos“ pod čím si môžeme v doslovnom preklade predstaviť „bezmenný“. (Sklalický, 2020)

Existuje množstvo ďalších definícií, ktoré pojem vysvetľujú. Univerzita Tomáše Bati definuje anonymitu ako schopnosť byť nepoznaný, čiže neodlišný od zbytku. (n.d.) Hořejš podotýka na fakt, že anonymita je používaná po stáročia k šíreniu dôležitých informácií bez toho, aby bol autor identifikovaný. (2014, s.10)

S príchodom internetu anonymita nabrala úplne nový význam a je stále viac rozoberanou témou. Skupine aktivistov Cypherpunk sa pripisuje prvé polemizovanie nad otázkou anonymity práve vo vzťahu k internetu. Táto komunita sa zameriava na ochranu súkromia a slobodu jednotlivca s dôrazom na potrebu anonymných komunikačných nástrojov v online priestore. (Skalický, 2020)

Dosiahnuť úplnú anonymitu na internete je skoro nemožné a užívateľa je možné dohľadať vždy. Túto skutočnosť veľmi zvyšuje využívanie rovnakých metód anonymity. Môže to byť napríklad pri využívaní rovnakej prezývky alebo aj bez potreby overenia identity je každá IP adresa zapísaná do logov a dohľadateľná. Napriek tomu je možné podniknúť kroky, s ktorými sa k zvýšenej anonymite priblížime. (Sklalický, 2020)

Podľa Skalického majú poskytovatelia internetu prístup k histórií vyhľadávania aj napriek využitia anonymných služieb. Tieto dáta môžu byť následne ďalej predávané na marketingové účely. (2020)

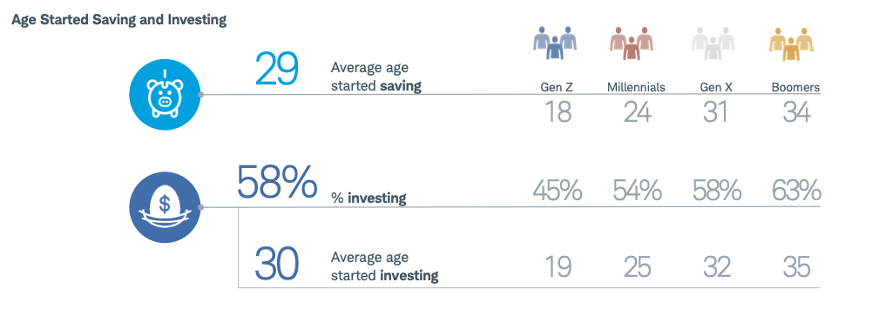

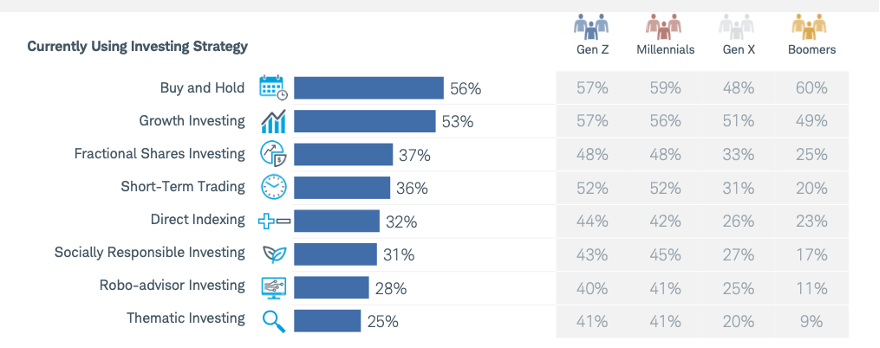

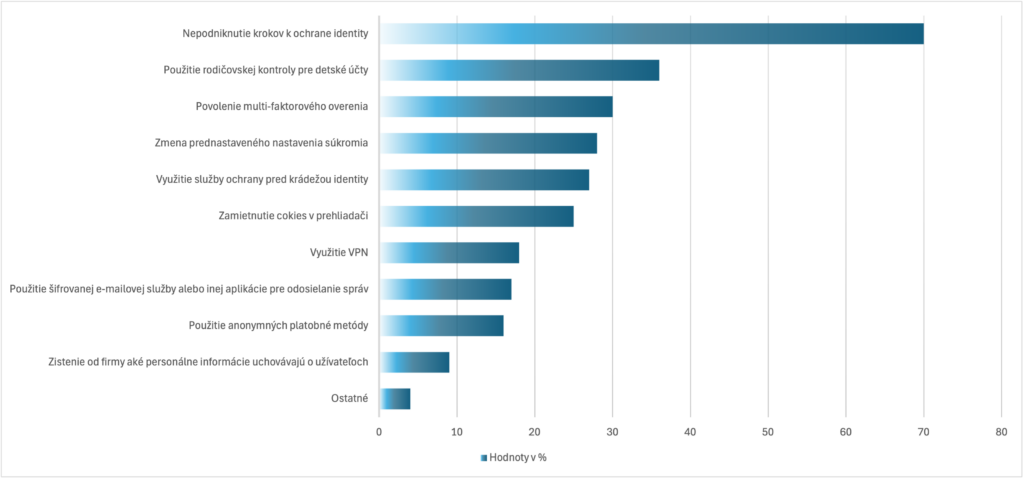

Podľa grafu č. 2.1 až 70% užívateľov internetu nepodniká žiadne kroky k ochrane svojej identity. Dôvody k ich prístupu môžu byť rôzne, od mylného pocitu bezpečia cez neznalosť dostupných riešení až po podceňovanie rizík.

30% respondentov využíva multifaktorovú autorizáciu a 28% mení prednastavené nastavenia súkromia. Aj tieto kroky môžu značne prispieť k zvýšenej anonymite.

Graf 2.1 Podniknutie krokov k ochrane identity na internete (Petrosyan, 2023)

Anonymita nás môže priniesť súkromie, slobodu prejavu a bezpečie. Na dosiahnutie spomenutých cieľov je možné využiť rôzne nástroje, ktorým sa bude práca venovať v ďalšej podkapitole. Na druhej strane je potrebné podotknúť, že anonymita môže vytvárať priestor pre kyberšikanu, dezinformácie a nelegálne aktivity. Preto je dôležité byť v prostredí internetu vždy opatrný a obozretný.

1.2 Vybrané nástroje

Anonymita bola na internete zaručená približne do polovice 90. rokov. Postupne sa začalo s analýzami IP adries alebo zberom dát. Dnes už úplná anonymita nie je možná, napriek tomu existujú nástroje, ktoré nám umožnia sa k nej priblížiť. Existuje niekoľko dostupných nástrojov. (Mazúr, 2016) S narastajúcim významom ochrany súkromia je stále môžeme v budúcnosti očakávať aj príchod novších a sofistikovanejších nástrojov.

1.2.1 Upravené operačné systémy

Operačné systémy sú špeciálne upravené s cieľom obmedziť sledovanie. Napríklad Linuxové operačné systémy Whonix a Tails, ktoré sú bežne smerované cez sieť Tor. Whonix je známy svojou silnou izoláciou sieťovej prevádzky a aplikácií, vďaka čomu je dobrou voľbou pre používateľov, ktorí uprednostňujú bezpečnosť. Na druhej strane Tails je navrhnutý tak, aby bol užívateľsky prívetivejší a prenosnejší, vďaka čomu je ideálny pre tých, ktorí oceňujú jednoduché použitie a anonymitu. (Dezso, 2024)

1.2.2 Anonymné vyhľadávače

Vyhľadávače neuchovávajú dáta o aktivite užívateľa. Napríklad DuckDuckGo, ktorý je bežne predvolený pri väčšine Tor inštalácií. Na rozdiel od bežných prehliadačov ako Google nezaznamenáva osobné údaje, neukladajú históriu a neprofiluje užívateľa na základe jeho správania. (Sklalický, 2020) Existuje aj špeciálny vyhľadávač Startpage, kombinujúci anonymné vyhľadávanie s výsledkami od Google.

1.2.3 Doplnky prehliadača

Doplnky obmedzujú zber dát o užívateľovi pomocou blokovania sledovacích skriptov a reklám. Patrí medzi ne napríklad: Ghostery, uBlock Orgin, Privacy Badger. Doplnky sa odporúča využívať s ďalšími nástrojmi podporujúcimi anonymitu ako anonymné vyhľadávače alebo VPN.

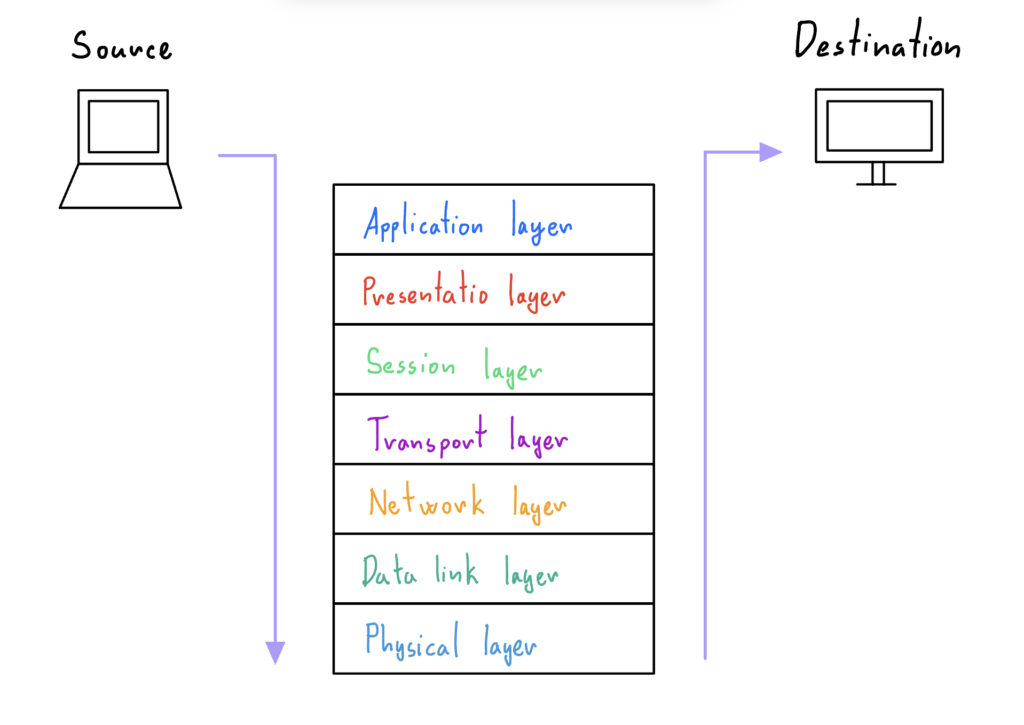

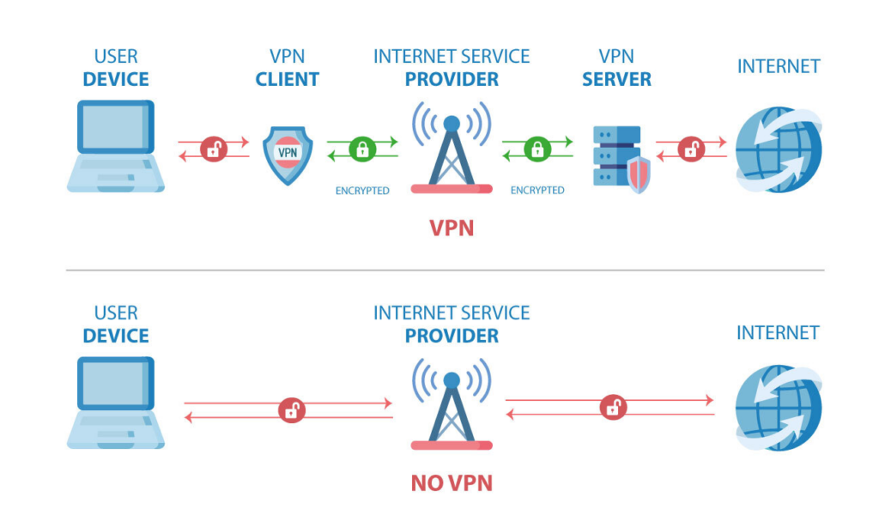

1.3 VPN

Virtual Private Network (VPN) je technológia umožňujúca zaradenie súkromnej siete pomocou zdieľanej alebo verejnej infraštruktúry. VPN je systém medzi sebou prepojených zariadení tvoriacich zabezpečenú súkromnú sieť. Dáta sú naprieč sieťou odosielané cez šifrovaný tunel zobrazený na obrázku 2.1, ktorý zariadenia prepája. Práve šifrovaný tunel sa stará o zabezpečenie toku dát. Výhodou VPN je, že webový server vidí IP adresu danej VPN namiesto užívateľovej skutočnej IP adresy. (Gavenda, 2021) (Mazúr, 2016) Existujú tri typy VPN: point-to-point, point-to-site a site-to-site.

Obrázok 2.1 Ako funguje VPN (Waasem, 2023)

VPN má viacero využití. Vo veľkom ju využívajú organizácie na prepojenie svojich pobočiek na centrálu. Okrem toho VPN dokáže skryť vyhľadávanie histórie na Internete. (Gavenda, 2021)

VPN splňuje základné bezpečnostné otázky autorizácie, autentifikácie, dôveryhodnosti a integrity. Autorizácia umožňuje užívateľom prístup na základe ich práv. Autentifikácia overuje identitu užívateľa. Overenie prebieha pomocou zdieľaných kľúčov alebo digitálneho podpisu. Dôveryhodnosť VPN je zabezpečená pomocou šifrovania. Integrita má na starosti, aby dáta dorazili do cieľa v rovnakej podobe ako boli odoslané. Inak povedané neboli pozmenené alebo poškodené pri prenose napríklad útočníkom. (Gavenda, 2021)

Podľa prieskumov hlavný dôvod využívania VPN je ochrana súkromia, anonymné prehliadanie internetu a bezpečná komunikácia. (Borgeaud, 2024)

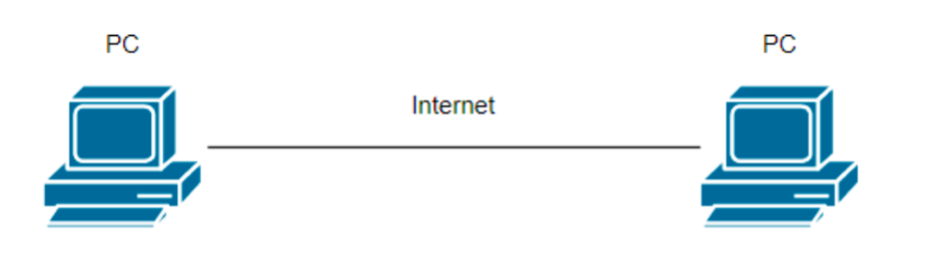

1.3.1 Point-to-point

Najpoužívanejší typ spojenia pri VPN. Jedná sa o trvalé priame komunikačné spojenie medzi dvoma stranami. V závislosti od typu môže byť toto spojenie použité pre rôzne aplikácie. Často sú týmto spôsobom vzájomne prepojené počítačové centrá alebo firemné pobočky so svojim ústredím. (Gavenda, 2021, s. 11)

Obrázok 2.2 Point-to-point spojenie (Gavenda, 2021)

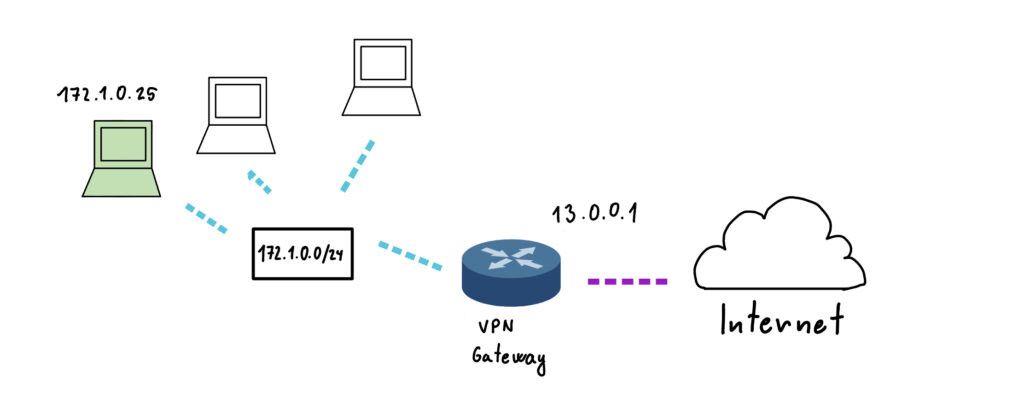

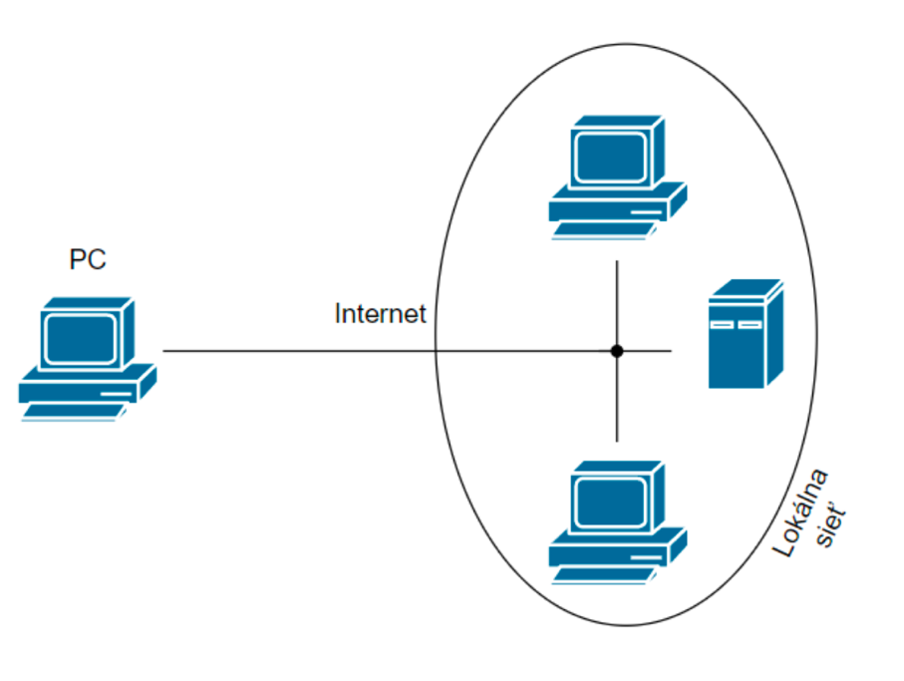

1.3.2 Point-to-site

Point-to-site je typ vytvárajúci bezpečné pripojenie k VPN pomocou užívateľského zariadenia, napríklad počítača. Užívateľské zariadenie toto pripojenie vytvorí a začne komunikáciu so sieťou ku ktorej pristupuje. Príkladom tohto spojenia môže byť pripojenie zamestnanca do firemnej siete zo vzdialeného miesta (iného mesta, apod.). Tento zamestnanec teda môže pristupovať ku všetkým dátam zo siete tak, akoby bol priamo vo firme. (Gavenda, 2021, s. 11, 12)

Obrázok 2.3 Point-to-site spojenie (Gavenda, 2021)

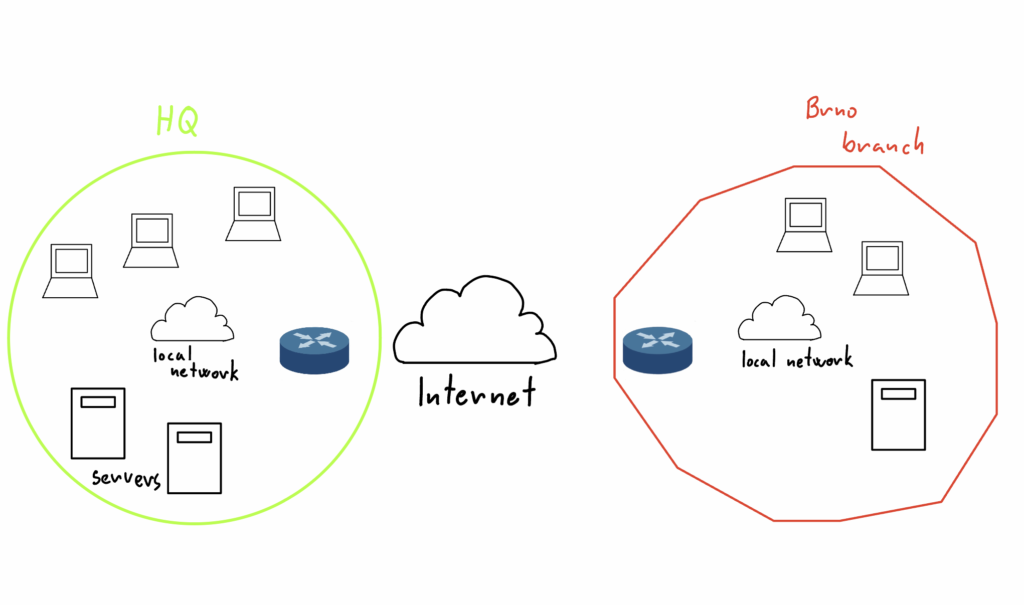

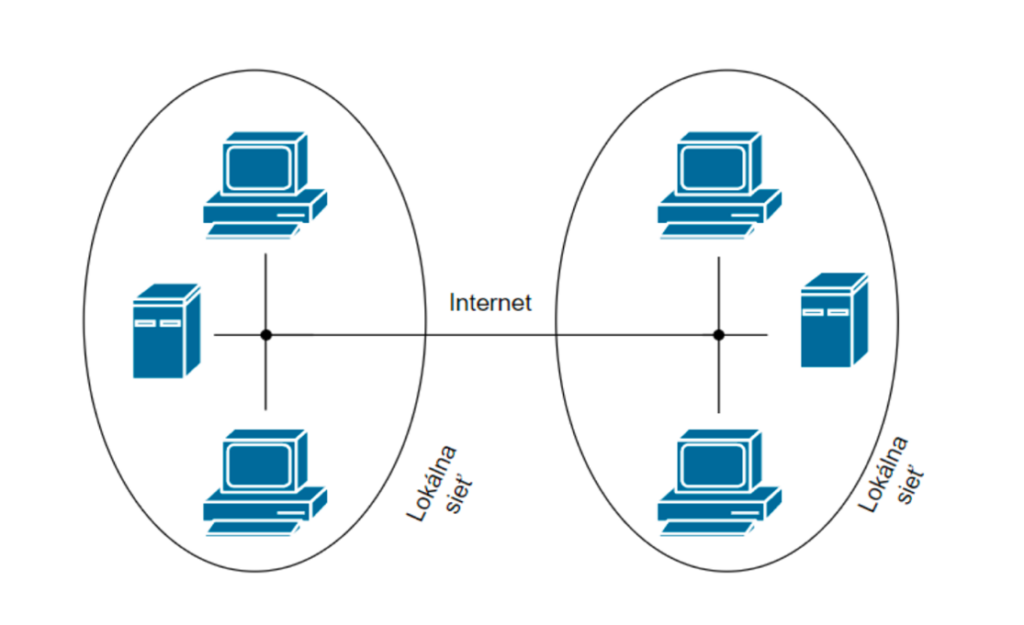

1.3.3 Site-to-site

Spojenie medzi dvoma alebo viacerými sieťami, napríklad medzi hlavnou podnikovou sieťou a sieťou pobočiek v rôznych častiach sveta. Vďaka tomuto spojeniu môže spoločnosť bezpečne prepojiť svoju podnikovú sieť so vzdialenými kanceláriami. Pri komunikácií a zdieľaní zdrojov sa toto spojenie chová ako jedna veľká sieť. (Gavenda, 2021, s. 12)

Obrázok 2.4 Site-to-site spojenie (Gavenda, 2021)

1.3.4 Obmedzenia VPN

Hoci VPN predstavuje účinný nástroj na ochranu súkromia a zvýšenie bezpečnosti, jej používanie nie je bez rizík. Používatelia by si mali byť vedomí možných obmedzení a zvážiť výber kvalitnej služby s ohľadom na ich potreby a podmienky legislatívy v danej krajine.

Zníženie rýchlosti internetového pripojenia je jedným z najčastejších problémov pri používaní VPN. Tento problém vzniká kvôli pridanému kroku v podobe VPN tunelu. Tunel šifruje a presmeruje dáta cez vzdialený server, čo môže spomaliť celkové pripojenie. Miera spomalenia závisí od kvality VPN servera, jeho vzdialenosti od užívateľa a aktuálneho zaťaženia siete. To môže byť problematické najmä pri streamovaní videí, online hrách alebo iných aktivitách vyžadujúcich vysokú rýchlosť internetu. (DeMeyer, n.d.)

Aj keď VPN poskytuje vyššiu úroveň ochrany súkromia, bezpečnosť celého systému závisí od poskytovateľa služby. Ak má poskytovateľ slabé zabezpečenie, dáta užívateľov môžu byť odhalené alebo zneužité. Niektorí poskytovatelia si dokonca môžu ukladať záznamy o aktivitách používateľov, čo je v rozpore so základnou myšlienkou anonymity. Je preto dôležité vyberať poskytovateľa s dobrou reputáciou a transparentnou politikou ochrany dát. (DeMeyer, n.d.)

Kompatibilita VPN môže byť problémom najmä pri použití starších zariadení alebo operačných systémov. Niektoré VPN služby nemusia byť plne kompatibilné s určitými platformami, čo môže obmedziť ich využiteľnosť. Tieto problémy sa prejavujú napríklad vo forme výpadkov spojenia alebo nemožnosti nainštalovať VPN aplikáciu na konkrétny operačný systém či zariadenie (DeMeyer, n.d.).

V niektorých krajinách je používanie VPN prísne regulované alebo úplne zakázané. Napríklad v Bielorusku, Iraku, Severnej Kórei, Ománe a Turkmenistane je VPN ilegálna. Okrem toho existujú krajiny, ako napríklad Čína, Rusko alebo Spojené arabské emiráty, kde je používanie VPN povolené len za určitých podmienok a s obmedzeniami. To znamená, že užívatelia v týchto regiónoch môžu čeliť právnym následkom, ak sa rozhodnú používať neschválené VPN služby. (Howarth, 2024).

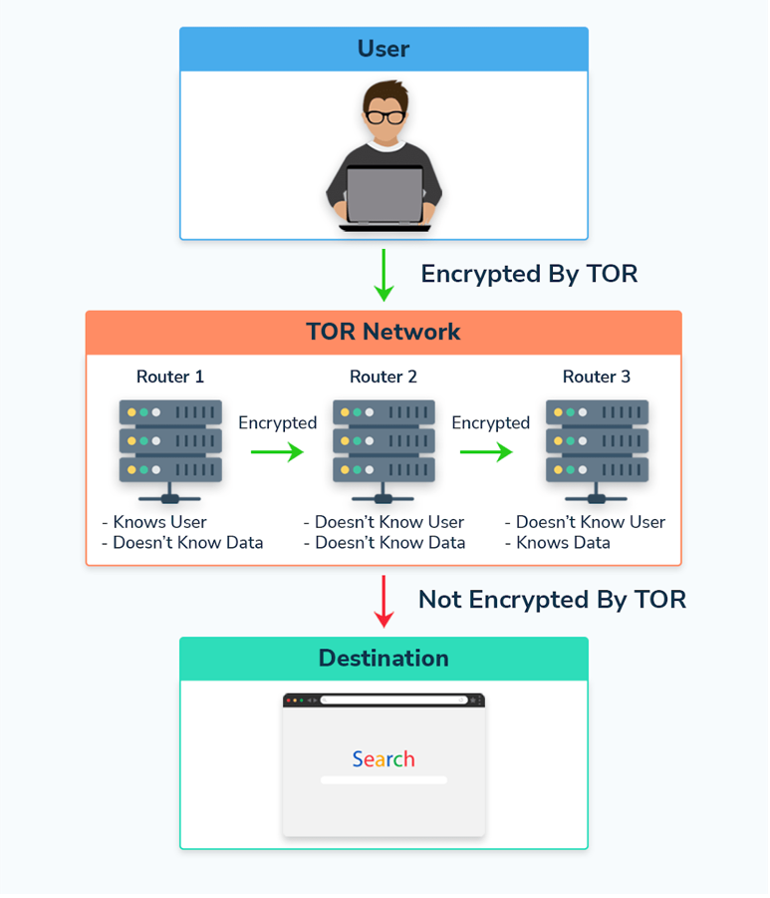

1.4 Tor

The Onion Router (cibuľový smerovač) je špeciálny druh anonymizujúcej sieťovej služby, ktorá je podobná službám VPN. Rozdiel medzi TOR a VPN je ten, že TOR sa správa ako viacreťazové VPN, pretože dáta cestujú zašifrované cez početné uzly situované v rôznych lokalitách na svete, čím zabezpečuje vysokú ochranu pred sledovaním. (Sklalický, 2020, s.57)

Pri prvom spustení prehliadača má užívateľ možnosť výberu medzi konfiguráciou prehliadača alebo pripojením do siete Tor. Vyhľadávač Tor používa engine DuckDuckGo. (Sklalický, 2020)

Obrázok 2.5 zobrazuje užívateľa, ktorý najprv odošle dáta cez Tor klienta. Klient dáta zašifruje čím sú chránené. Tor využije systém troch prechodových uzlov na spracovanie dát. Vstupný uzol vie, kto je užívateľ (IP adresa) ale nevidí obsah zašifrovaných prenášaných dát. Stredný uzol nemá informácie o užívateľovi ani o obsahu prenášaných dát. Účel druhého uzla je preto iba presmerovanie dát na ďalší, posledný uzol. Tento krok značne prispieva k anonymizácií. Výstupný uzol nepozná užívateľa ale dokáže vidieť šifrované dáta. Tretí uzol následne odošle dáta na cieľovú destináciu.

Obrázok 2.5 Ako funguje Tor (Dezso, 2024)

Tor funguje na princípe vstveného šifrovania. Každá vrstva odhaľuje minimum informácií, čo zabezpečuje anonymitu. Proces znemožňuje jednotlivým uzlom alebo tretím stranám spájať používateľa s jeho online aktivitami.

Po službe TOR môžu siahať nasledujúci užívatelia:

- Osoby snažiace sa prekonať reštriktívne obmedzenia k prístupu k zahraničným informáciám,

- Osoby snažiace sa o obmedzenie sledovania webových servermi (napr. za účelom reklamy),

- Novinári pri vyhľadávaní informácií do článku kvôli zaisteniu anonymity

- Zamestnanci neziskových organizácií pri pripájaní k infraštruktúre svojej organizácie bez toho aby dávali monitorovací nástrojom vedieť že sú zamestnancami neziskovej organizácie,

- Firmy monitorujúce svoju konkurenciu,

- Agenti a iné zložky úradov činných v trestnom konaní pri vyšetrovaní,

- Zločinci pre výmenu informácií alebo páchaní trestnej činnosti.

(Zachar, 2022, s.74)

Za predchodcom siete Tor je považovaná sieť Mixnet. Mixnet umožňuje odosielateľovi posielanie správ s náhodným výberom serverov (mixov) v sieti. Správa je pred odoslaním náhodne a opakovane premiešanú. Následne je správa doručená prijímateľovi. Mixnet obsahoval bezpečnostné nedostatky a tak vznikol systém Onion Routing pre anoynymizáciu spojení rôznych aplikácií. Do praxe sa dostala až ďalšia generácia, ktorá je známa pod názvom Tor. (Zachar, 2022)

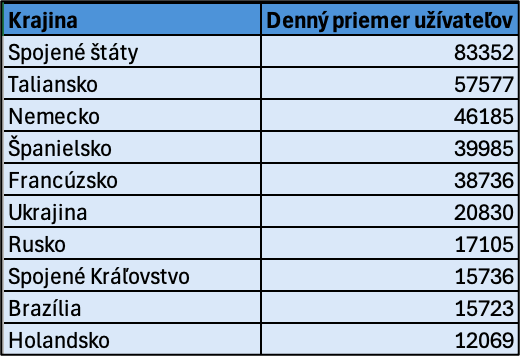

Tabuľka 2.1 Denný priemer užívateľov služby Tor (Zachar, 2022)

1.4.1 Obmedzenia Tor

Jedným z najvýraznejších obmedzení siete TOR je jej nízka rýchlosť, ktorá je priamym dôsledkom spôsobu, akým táto sieť funguje. Dátové pakety, ktoré užívateľ posiela a prijíma, neprechádzajú priamo medzi jeho zariadením a cieľovým serverom, ako je to v prípade tradičného internetového pripojenia. Namiesto toho sú tieto pakety presmerované cez niekoľko náhodne vybraných uzlov, ktoré tvoria vrstvu šifrovania a anonymizácie. Na každom z týchto uzlov sú dáta zašifrované alebo dešifrované, čo výrazne zvyšuje dobu prenosu. Z pohľadu bežného používania to znamená, že užívatelia môžu zažiť oneskorenia pri načítavaní webových stránok alebo pri sťahovaní súborov. Tieto oneskorenia môžu byť nepríjemné, no stávajú sa skutočnou prekážkou pri činnostiach náročných na šírku pásma, ako je streamovanie videa vo vysokom rozlíšení, hranie online hier alebo používanie aplikácií vyžadujúcich nízku latenciu. Pre takéto aktivity je sieť TOR v podstate nepoužiteľná. (Mazúr, 2016)

Hoci je sieť TOR navrhnutá tak, aby poskytovala vysokú úroveň anonymity, táto ochrana nie je nepreniknuteľná. Jednou z najznámejších metód útoku na anonymitu siete TOR je tzv. korelácia dát. Táto technika umožňuje sofistikovaným útočníkom, napríklad vládnym agentúram alebo organizáciám s dostatočnými zdrojmi, sledovať prenosy dát na vstupných a výstupných uzloch siete. Pri korelácii dát sa analyzujú časové údaje a objemy prenášaných dát. Ak útočník kontroluje alebo monitoruje dostatočne veľký počet uzlov, môže porovnávaním identifikovať, ktoré prenosy na vstupnom uzle odpovedajú prenosom na výstupnom uzle. Takýmto spôsobom je možné odhaliť pôvodcu komunikácie a jej cieľ, čím sa anonymita používateľa naruší. Táto slabina je obzvlášť nebezpečná v situáciách, keď je anonymita kritická, napríklad pre novinárov, aktivistov alebo whistleblowerov v autoritárskych režimoch. (Mazúr, 2016)

Ďalšou nevýhodou siete TOR je, že jej použitie môže byť samé o sebe považované za podozrivé. TOR síce ponúka anonymitu, ale zároveň môže signalizovať, že používateľ má záujem skryť svoju aktivitu. Poskytovatelia internetového pripojenia (ISP) alebo vládne agentúry si môžu všímať, že konkrétne zariadenie pristupuje na sieť TOR. V niektorých krajinách alebo prostrediach môže byť toto považované za dôvod na bližšie monitorovanie užívateľových aktivít. Táto situácia vytvára paradox: hoci TOR umožňuje ochranu súkromia, už samotné jeho používanie môže užívateľa vystaviť zvýšenému záujmu zo strany autorít. Riešením môže byť použitie dodatočných nástrojov, ako je VPN pred pripojením na TOR, no aj to so sebou nesie isté technické a finančné nároky. (Mazúr, 2016)

Architektúra siete TOR je závislá na dobrovoľníkoch, ktorí spravujú uzly. Tieto uzly sú základným stavebným prvkom siete, pretože umožňujú smerovanie a šifrovanie dát. Avšak tento decentralizovaný systém prináša so sebou aj riziká. Nie je možné úplne preveriť ani kontrolovať každého správcu uzla. Ak sa do siete dostane útočník, ktorý má pod kontrolou väčší počet uzlov, môže vykonávať rôzne druhy útokov, napríklad pasívne sledovanie prenosov, alebo dokonca manipuláciu s dátami. Osobitné riziko predstavujú výstupné uzly, ktoré komunikujú s cieľovými servermi. Správca výstupného uzla môže teoreticky sledovať nešifrovanú komunikáciu, čo je problém pre užívateľov, ktorí nepridávajú ďalšie vrstvy šifrovania. To znamená, že anonymita môže byť narušená nie kvôli slabinám samotnej technológie TOR, ale kvôli rizikám vyplývajúcim zo správy infraštruktúry. (Mazúr, 2016)

Anonymita na internete predstavuje komplexnú tému s mnohými aspektmi, od technológie až po etické otázky. Ako ukázala táto práca, anonymita nie je len nástrojom zločincov, ale aj spôsobom ochrany súkromia a slobody prejavu pre množstvo bežných užívateľov, novinárov, aktivistov či organizácií. Technológie ako VPN a Tor poskytujú užívateľom možnosť zvýšiť svoju bezpečnosť a chrániť svoje údaje pred zneužitím.

Napriek pokroku v oblasti nástrojov na zabezpečenie anonymity, úplnú anonymitu na internete dosiahnuť nie je možné. Obmedzenia týchto technológií zahŕňajú technické nedostatky, legislatívne obmedzenia a riziká spojené s nedôveryhodnými poskytovateľmi služieb. Používateľom teda zostáva možnosť zvýšiť svoju ochranu kombináciou viacerých opatrení, napríklad využívaním anonymných vyhľadávačov, VPN, siete Tor a dodržiavaním bezpečnostných zásad.

Je však potrebné si uvedomiť, že anonymita na internete má aj svoje tienisté stránky, ako podporu šírenia dezinformácií či zneužívanie na nelegálne aktivity. Preto je dôležité pristupovať k tejto problematike obozretne a vnímať ju nielen ako technologický, ale aj spoločenský fenomén.

Celkovo práca poukazuje na význam ochrany súkromia a potrebu vyváženého prístupu, ktorý umožní zabezpečiť anonymitu pre legitímnych užívateľov a zároveň minimalizovať jej zneužívanie. Vývoj nových technológií a legislatívnych opatrení bude v tejto oblasti naďalej kľúčový.

Borgeaud, A. (2024). Reasons for VPN usage worldwide 2023. Statista. https://www.statista.com/statistics/1343692/worldwide-virtual-private-network-reasons-usage/

DeMeyer, Z. (n.d.). Five Disadvantages of Using VPNs. Todyl. Cit 08. december 2024, z https://www.todyl.com/blog/disadvantages-using-vpns

Dezso, R. (2024, máj 15). Whonix vs Tails (Differences You Must Know in 2024). STATIONX. https://www.stationx.net/whonix-vs-tails/

Gavenda, M. (2021). Možnosti bezpečného VPN přístupu [Univerzita Tomáše Bati ve Zlíně. Fakulta aplikované informatiky, Ústav počítačových a komunikačních systémů]. Univerzita Tomáše Bati ve Zlíně. http://hdl.handle.net/10563/46048

Hořejš, Bc. J. (2014). ANONYMNÍ POHYB V SÍTI INTERNET [VYSOKÉ UČENÍ TECHNICKÉ V BRNĚ]. https://theses.cz/id/wnhj5c/129352_Diplomov_Prce_Hoej_Jan_SIX.pdf

Howarth, J. (2023, január 23). 30+ VPN Statistics, Trends & Facts (2024-2027). Exploding Topics. https://explodingtopics.com/blog/vpn-stats

Kapitola 7—Anonymita na internetu. (n.d.). Univerzita Tomáše Bati ve Zlíně. Cit 08. december 2024, z https://www.utb.cz/cvt/bezpecnost-anonymita-na-internetu/

Mazúr, F. (2016). Bezpečnosť a možnosti zachovania anonymity na Internete [Univerzita Tomáše Bati ve Zlíně. Fakulta aplikované informatiky, Ústav počítačových a komunikačních systémů]. Univerzita Tomáše Bati ve Zlíně. http://hdl.handle.net/10563/38461

Misata, K. (2013). The Tor Project: An inside view. XRDS: Crossroads, The ACM Magazine for Students, 20(1), 45–47. https://doi.org/10.1145/2510125

Petrosyan, A. (2023). Online privacy measures worldwide 2023. Statista. https://www.statista.com/statistics/617422/online-privacy-measures-worldwide/

Skalický, J. (2020). Anonymita na Internetu [Univerzita Tomáše Bati ve Zlíně. Fakulta aplikované informatiky, Ústav informatiky a umělé inteligence]. Univerzita Tomáše Bati ve Zlíně. http://hdl.handle.net/10563/47875

Zachar, Š. (2023). Úvod do anonymných sietí—História ich vzniku a základné prvky. AKTUÁLNE VÝZVY KYBERNETICKEJ BEZPEČNOSTI. https://cybercompetence.sk/wp-content/uploads/dokumenty/kniznica/zborniky_a_prezentacie/AVKB_zbornik_2022.pdf