Současná digitální éra je charakterizována extrémním množstvím online dat a rostoucím tlakem na firmy rychle tato data zpracovávat. Competitive Intelligence (CI) se z nástroje strategických oddělení posunula do běžné praxe organizací napříč obory, neboť stále větší část veřejné komunikace probíhá v online prostředí. Subjekty schopné systematicky sbírat, třídit a interpretovat data tím získávají konkurenční výhodu. Klíčovým předpokladem je přístup k relevantním zdrojům a jejich rychlé zpracování, kde vstupuje do hry web scraping. Web scraping umožňuje analyzovat informace v měřítku, které by dřívější manuální rešerše nedokázala pokrýt.

V oblasti konkurenčního zpravodajství mají zvláštní význam tiskové zprávy. Tiskové zprávy jsou prvotním zdrojem informací, které se teprve později dostávají do mediálního pokrytí. Pro CI představují médium, v němž lze zachytit jemné tržní signály dříve než konkurence. V českém prostředí je nejvýznamnějším distribučním kanálem služba Protext ČTK, která umožňuje firmám publikovat tiskové zprávy prostřednictvím infrastruktury České tiskové kanceláře (Protext, 2025).

Tato esej zkoumá, jak lze data eticky a legálně vytěžovat z platformy Protext a jaké limity vyplývají z povahy tiskových zpráv. Současně ukazuje, jak může systematická práce s tímto typem zdroje odhalit trendy a dynamiku jednotlivých odvětví. V praktické rovině představuje funkční Python skript pro scraping veřejně dostupný na platformě GitHub.

Metodologie

Informační základna práce byla vybudována prostřednictvím rešerše zejména v databázi Google Scholar. Zdroje byly poté doplněny o primární legislativu, odborné blogové články a oficiální dokumentace softwarových knihoven.

Pro efektivní zpracování praktické i teoretické části byly využity nástroje umělé inteligence. Vývoj praktického projektu (nástroje protext-scraper) probíhal v „AI-native“ vývojovém prostředí Cursor. Tento nástroj umožnil akceleraci psaní kódu v jazyce Python, optimalizaci využití knihoven Beautiful Soup a Requests a řešení technických problémů při scrapingu. Pro syntézu teoretických poznatků, strukturaci argumentace a stylistickou korekci textu byly podpůrně využity jazykové modely NotebookLM, Gemini 3 a ChatGPT 5.1. Tyto modely sloužily výhradně jako nástroj pro formování textu, nikoliv jako zdroj primárních dat.

Web scraping

Od crawlingu ke scrapingu

Původní webové technologie pro sběr dat byly zaměřeny na crawling (neboli indexaci). Crawling je systematické navštěvování webových stránek za účelem indexace obsahu, například pro vyhledávače pomocí crawlerů1 (Tseriotis, 2025).

Z crawlingu se postupně vyvinul scraping. Web scraping je technika automatického získávání, třídění a využívání dat z konkrétních webových stránek. Crawling býval často zaměňován se scrapingem, nebo dokonce označován jako synonymum (Kawase, 2023).

Principy scrapingu

Proces scrapingu vyžaduje detailní pochopení struktury cílové webové stránky, aby bylo možné data jednak legálně data získat, jednak efektivně extrahovat. V této kapitole jsou shrnuty základní principy webového scrapingu.

Technický proces web scrapingu je v podstatě programovou emulací toho, co vykonává webový prohlížeč (Fortinet, Inc., 2025). Stáhne HTML kód, přečte jej a najde relevantní informace. Jakmile scraper získá tento surový text pomocí HTTP požadavku, musí jej analyzovat. K tomu slouží nástroj zvaný parser, který z HTML vytvoří strukturovanou reprezentaci nazývanou Document Object Model (DOM). DOM představuje stromovou strukturu, kde každý prvek stránky – text, obrázek či odkaz – tvoří list nebo větev tohoto stromu.

Parsování lze realizovat pomocí specializovaných knihoven, například Beautiful Soup2 v jazyce Python. Tento nástroj umožňuje snadno se v DOM stromě navigovat a vyhledávat konkrétní prvky. Pro cílenou extrakci dat je nezbytné přesně specifikovat, kde se požadované informace nacházejí, k čemuž slouží selektory. Tyto selektory využívají syntaxi CSS selektorů nebo XPath dotazů k výběru konkrétních částí DOM (Hajba, 2018).

Webové stránky nemají vždy stejnou strukturu, což je pro scraping problematické. Místo spoléhání se na jediný selektor lze implementovat postupné zkoušení několika možností, lze například nejprve hledat specifický HTML element s přesnými atributy, následně obecnější variantu, a nakonec záložní řešení. Tento proces však nemusí být spolehlivý a dlouhodobě fungující, proto je kód potřeba udržovat a aktualizovat. Některé stránky, zejména sociální sítě jako Facebook, se proti tomu brání obfuskací selektorů nebo jejich častou změnou (Clark, 2021).

Mnoho moderních webových stránek generuje obsah dynamicky pomocí JavaScriptu (Client-Side Rendering). U takových stránek by pouhé stažení HTML kódu vedlo k prázdnému výsledku, neboť skutečný obsah se do dokumentu vkládá až po spuštění JavaScriptu v prohlížeči. Standardní řešení této situace vyžaduje použití tzv. headless browserů. Nástroje, umožňující headless browser, jako například Selenium nebo Scrapy dokážou JavaScript spustit a vykreslit finální podobu stránky. Samotnou extrakcí však proces nekončí, následuje totiž fáze čištění, ukládání dat.

Získaná surová data jsou často “zašuměná” (noisy) a obsahují chyby či nechtěné elementy, jako jsou reklamy, což je činí nevhodnými pro okamžitou analýzu. Proces předzpracování (pre-processing) je proto nezbytný pro převod materiálu do strojově čitelného a strukturovaného formátu. V praxi to zahrnuje normalizaci textu, sjednocování klíčů v tabulkách s proměnlivou strukturou nebo převod datových typů. U nestrukturovaného textu se využívají techniky zpracování přirozeného jazyka (NLP), jako je tokenizace, stemming a odstranění tzv. stop-slov (Tseriotis, 2025).

Vyčištěná data se exportují do formátů, které umožňují jejich další využití. Pro jednodušší datové sady se běžně využívají souborové formáty JSON a CSV. Efektivní variantou je formát JSON Lines (.jl), který umožňuje zápis dat průběžně, což minimalizuje riziko ztráty dat při přerušení procesu. Pro komplexnější projekty je vhodnější ukládání do databází. Ačkoliv klienti často vyžadují relační databáze (SQL), pro scraping se strukturálně lépe hodí NoSQL databáze (např. MongoDB), jelikož webové stránky jsou svou povahou dokumenty, což odpovídá logice NoSQL systémů (Hajba, 2018).

Automatizovaný sběr dat musí být realizován tak, aby nenarušil provoz cílového webu. Tento přístup, označovaný jako polite scraping, stojí na třech hlavních technických zásadách.

- Rate Limiting: Omezování rychlosti požadavků je klíčové, aby nedošlo k přetíženíserveru, což by mohlo být vyhodnoceno jako útok typu Denial-of-Service(Tseriotis, 2025.; Kawase, 2023).

- Identifikace (User-Agent): Scraper by se měl transparentně identifikovat v hlavičce HTTP požadavku a neměl by se vydávat za běžného uživatele, pokud to nenínezbytně nutné (Hajba, 2018).

- Respektování robots.txt: Z technického hlediska slouží soubor primárně jakoinstrukce pro crawlery, které části webu nemají navštěvovat. To samé platí i proscraping. Většina frameworků (např. Scrapy) umožňuje automatické dodržovánítěchto pravidel.

Výše uvedené principy řeší technickou proveditelnost a ohleduplnost k infrastruktuře, samotná legálnost sběru dat je otázkou mnohem komplexnější. Zda je data možné legálně stahovat a využívat, definuje právní rámec, kterému se věnuje následující kapitola.

Právní rámec scrapingu

Právní rámec web scrapingu pro tuto esej byl rozdělen do třech částí – autorské právo, ochrana osobních údajů (GDPR) a praktická smluvní omezení. V EU tyto oblasti dohromady určují, co lze z webu legálně extrahovat, jak s daty pracovat a kde končí hranice automatizovaného sběru.

Autorské právo

Z pohledu autorského práva naráží web scraping na základní překážku: technický proces stahování webových stránek nutně zahrnuje vytvoření jejich digitální rozmnoženiny (kopie). Aby byl tento sběr dat legální i bez výslovné licenční smlouvy s provozovatelem webu, musí se opírat o zákonnou výjimku. V evropském a českém právním řádu je touto klíčovou legalizační oporou tzv. vytěžování textů a dat (Text and Data Mining – TDM).

TDM definuje podmínky, za kterých lze automatizovaně analyzovat digitální obsah.

- Obecná výjimka pro komerční účely (§ 39c): Umožňuje komukoliv (včetně firempro účely CI) stahovat a analyzovat data, ke kterým má legální přístup. Tatosvoboda má však zásadní limit – platí pouze tehdy, pokud si vlastník webu těžbudat výslovně nevyhradil (tzv. digitální opt-out). V praxi se tento nesouhlasvyjadřuje strojově čitelným způsobem, nejčastěji prostřednictvím protokolurobots.txt. Pokud tedy robots.txt scraping zakazuje, výjimka TDM přestává platit asběr dat se stává nelegálním porušením autorského práva (Zákon č. 121/2000 Sb.,2000).

- Specifická výjimka pro vědecký výzkum (§ 39d): Tato část zákona je zásadní proakademické práce a výzkumné organizace. Poskytuje širší oprávnění než § 39c anení omezena výhradou autora (opt-outem). To znamená, že pro vědecké účely lzeza určitých podmínek vytěžovat data i v případě, kdy by to komerčnímu subjektubylo zakázáno (Zákon č. 121/2000 Sb., 2000).

Obě výjimky však sdílejí nutnou podmínku „zákonného přístupu“, což znamená, že TDM nelze aplikovat na obsah získaný z pirátských zdrojů nebo prolomením hesel. Pro tuto práci je tedy klíčové, že scraping Protextu spadá pod režim TDM, což jej činí legálním nástrojem analýzy, nikoliv krádeží obsahu (Čermák, 2025).

GDPR

Zatímco autorské právo chrání obsah, GDPR chrání jednotlivce. Zásadním omylem při sběru dat bývá předpoklad, že veřejně dostupná data na internetu nespadají pod ochranu osobních údajů. Nařízení GDPR se však vztahuje na veškeré informace o identifikované nebo identifikovatelné fyzické osobě, a to bez ohledu na jejich veřejnou dostupnost (Nařízení Evropského parlamentu a Rady (EU) 2016/679).

Identifikovatelnost osoby v digitálním prostředí není omezena pouze na jméno, ale zahrnuje i lokační údaje nebo síťové identifikátory (IP adresy, cookies), které mohou být použity k profilování. Pro účely Competitive Intelligence je proto klíčové držet soukromá data fyzických osob mimo scraping, aby se předešlo odpovědnosti za jejich případný únik.

Pokud ke zpracování osobních údajů dochází, musí mít správce (scraper) tzv. právní titul. V kontextu CI se nejčastěji uvažuje o titulu oprávněného zájmu správce. Jeho existence však není automatická a musí být pečlivě posouzena tzv. balančním testem, zda zájem firmy nepřevažuje nad základními právy subjektu údajů. S tím souvisí i následující principy.

- Minimalizace dat: Data musí být omezena na nezbytný rozsah pro daný účel (Nařízení Evropského parlamentu a Rady (EU) 2016/679).

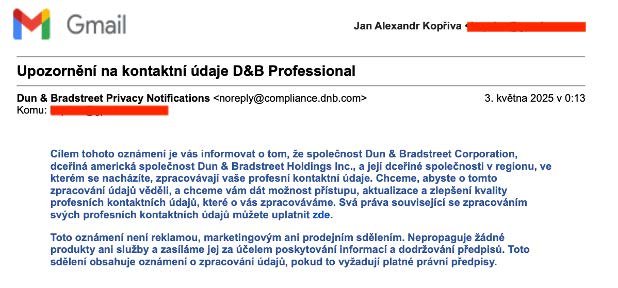

- Informační povinnost: I při získávání dat od třetích stran (scrapingem) má správcepovinnost informovat dotčené osoby o zdroji dat a účelu zpracování, a to vpřiměřené lhůtě (Nařízení Evropského parlamentu a Rady (EU) 2016/679). V praxije tato povinnost u masivního scrapingu obtížně splnitelná, což představujevýznamné právní riziko. Nicméně není nevykonatelná, viz. Obrázek 1 níže.

Obrázek 1: E-mail oznamující zpracování osobních dat v databázi společnosti Dun & Bradstreet

Zdroj: Vlastní zpracování autora.

Praktická a smluvní omezení

Kromě zákonů veřejného práva je scraping regulován také soukromoprávními smluvními vztahy, konkrétně Podmínkami užití (Terms of Service – ToS). Před zahájením extrakce je nezbytné prostudovat ToS cílového webu. Pokud podmínky obsahují klauzuli zakazující scraping (často hledáním klíčových slov jako crawler, spider, bot), a uživatel s nimi souhlasil, je touto smlouvou vázán (Kawase, 2023).

Tiskové zprávy jako datový korpus

Tiskové zprávy z platformy Protext, kterou provozuje Česká tisková kancelář, představují specifický žánr institucionální komunikace využívaný pro komerční i nekomerční účely. Jedná se o oficiální, verifikované texty opatřené metadaty (datum, kategorie, autor). Zprávy zpravidla dodržují strukturu tzv. obrácené pyramidy, kde klíčová fakta stojí na začátku, zatímco doplňující informace následují v dalších odstavcích (Tomandl, 2011). Tato předvídatelná struktura významně usnadňuje scraping.

Výhody tiskových zpráv

Hlavní předností tohoto zdroje je standardizace a kontinuita. Díky archivaci v Infobance ČTK vzniká konzistentní korpus pokrývající široké spektrum trhu od financí po veřejnou správu.

- Strukturovaná data: Pevná forma („kdo–co–kdy–proč“) zefektivňuje parsování a zvyšuje přesnost výstupů.

- Široká distribuce a relevance: Díky napojení na zpravodajské agregátory a média se informace dostávají k širokému publiku, což činí z Protextu relevantní zdroj pro monitoring tržního dění.

Limity tiskových zpráv

Při interpretaci dat je však nutné zohlednit zkreslení plynoucí z povahy PR komunikace a právního rámce.

- PR Bias: Tiskové zprávy jsou primárně nástrojem public relations, jehož cílem je budování kladné image a reputace (Tomandl, 2011). Negativní informace jsou v tomto žánru potlačeny, což vyžaduje kritický přístup k analýze sentimentu – texty nelze vnímat jako neutrální zpravodajství, ale jako propagační sdělení (Hejlová, 2015).

- Nereprezentativnost: Protext je placená služba. Dataset proto obsahuje pouze subjekty s rozpočtem na PR, zatímco menší hráči na trhu mohou zcela chybět. Data tedy reflektují komunikační aktivitu, nikoliv nutně reálný tržní podíl.

- Právní omezení: Na tiskové publikace se vztahuje zvláštní právo vydavatele dle § 87b Autorského zákona (Zákon č. 121/2000 Sb.). Ačkoliv se ochrana nevztahuje na jednotlivé údaje, systematické vytěžování a dlouhodobá archivace celých textů je mimo výjimky pro vědecký výzkum omezena (Směrnice Evropského parlamentu a Rady (EU) 2019/790).

Implementace scraperu a tvorba datasetu

Pro účely sběru dat byl v jazyce Python vyvinut pomocí nástroje Cursor specializovaný projekt protext-scraper5, který automatizuje extrakci tiskových zpráv přímo z portálu Protext.cz. Architektura nástroje byla navržena s důrazem na efektivitu sběru a striktní dodržování právních a etických norem definovaných v Kapitole 2.

Projekt je dostupný na platformě Github: https://github.com/koprjaa/protext-scraper

Architektura a technické řešení

Nástroj využívá hybridní přístup k identifikaci relevantních URL adres. Místo náročného plošného procházení webu (crawling) využívá scraper RSS kanál portálu (protext.cz/rss/cz.php) k detekci aktuálního rozsahu ID článků. Následně probíhá přímá iterace přes ID v definovaném rozsahu, kdy scraper konstruuje cílové URL ve formátu zprava.php?id={article_id}.

Technologicky je řešení postaveno na knihovně Beautiful Soup 4 pro parsování HTML kódu a knihovně Requests pro realizaci HTTP požadavků. Pro robustnost extrakce je využit parser lxml, který je schopen zpracovat i validně nedokonalé HTML dokumenty.

Právní a technická omezení

Před zahájením sběru proběhla analýza souboru robots.txt, která potvrdila, že provozovatel uplatňuje digitální opt-out specificky vůči AI botům (např. GPTBot, CCBot). Soubor však neobsahuje globální zákaz (User-agent: * Disallow: /). Nástroj protext-scraper byl proto nakonfigurován tak, aby tyto podmínky respektoval. Scraper využívá vlastní User-Agent řetězec, který jej identifikuje jako akademický projekt, nikoliv jako komerční AI bot. Tím technicky nespadá do skupiny blokovaných agentů. Ačkoliv technické nastavení webu sběr dat neblokuje, projekt se pro jistotu opírá i o zákonnou licenci pro vytěžování textů a dat pro účely vědeckého výzkumu dle § 39d zákona č. 121/2000 Sb., která není dotčena případnými technickými výhradami směřovanými na komerční subjekty.

Struktura datasetu

Výstupem je JSON soubor, kde každý záznam obsahuje:

- titulek (Title),

- obsah (Content),

- metadata (Link, ID, Date, Keywords a Category).

Příklad jednoho z výstupů:

{ “title”: “U Příbora silničáři opravují frekventovanou silnici nad dálnicí”,

“content”: “Přibližně jeden měsíc bude trvat dopravní omezení na silnici I/58 v lokalitě u dálnice D48 na úrovni Příbora. Důvodem je oprava povrchu silnice, přičemž část opravy se týká mostu nad dálnicí. Jan Rýdl, mluvčí ŘSD: “Od pátku 3. října začínáme s opravou obchvatu Příbora. Více než 3,5 km silnice I/58 vyžaduje nový povrch, proto vyměníme asfaltové vrstvy formou recyklace materiálu za horka přímo na místě. Cena prací přesahuje 24 milionů korun a hotovo budeme mít nejdéle do poloviny listopadu.” Silničáři si jednotlivé fáze opravy naplánovali tak, aby na sebe plynule navazovaly. Zatímco na jednom místě ještě opravovali dilatační spáry, z druhé strany už pokládali první vrstvu asfaltu. Po dobu oprav je v místě snížena rychlost. Dopravní situace se mění průběžně podle jednotlivých fází opravy vozovky a může docházet i k dočasnému uzavření provozu. Některé sjezdy a nájezdy v místě mimoúrovňového dálničního křížení jsou uzavřené. Doprava je vedena po vyznačených objízdných trasách. Motoristé by při projíždění celého úseku měli věnovat pozornost dopravnímu značení, které se může průběžně měnit. V době provozu stavební techniky po vozovce je nutné dbát pokynů pracovníků stavby. Pokud půjde vše bez komplikací, měla by se dopravní situace v místě rekonstrukce vrátit k normálu do půlky listopadu. Zdroj: POLAR televize Ostrava PROTEXT”,

“link”: “https://www.protext.cz/zprava.php?id=54653”,

“id”: 54653,

“date”: “Příbor 10. října 2024 (PROTEXT)”,

“keywords”: “Protext-ČR-doprava-dopravniinfo.tv-VIDEOSTREAM-UPOZORNĚNÍ”,

“category”: “Auto-moto, doprava a stroje” }

Využití pro Competitive Intelligence

Získaný dataset tiskových zpráv představuje pro analytika Competitive Intelligence (CI) cenný zdroj primárních dat. Na rozdíl od nestrukturovaného šumu sociálních sítí, tiskové zprávy odrážejí oficiální komunikační strategii sledovaných subjektů a jejich snahu o řízení reputace (reputation management) a budování důvěry (Prozrová, 2020; Nsibande et al., 2025). Analýzou tohoto korpusu lze rekonstruovat, jak chtějí být konkurenti vnímáni trhem a jaká témata se snaží aktivně nastolovat.

Kvantitativní obsahová analýza (QCA)

Základní metodou možného zpracování datasetu je kvantitativní obsahová analýza (QCA), která patří mezi nejužívanější metody výzkumu médií pro svou schopnost objektivně zpracovat velké objemy textu (Špundová, 2024). V kontextu CI umožňuje QCA transformovat textová data na měřitelné ukazatele a sledovat strategické priority konkurence.

Klíčovým prvkem této metody je frekvenční analýza. Měřením četnosti klíčových slov v poli content a keywords lze identifikovat tzv. mediální agendu. Pokud například v komunikaci konkurenta dlouhodobě narůstá frekvence pojmů jako “udržitelnost” nebo “umělá inteligence”, indikuje to strategický posun, na který může firma reagovat ještě před uvedením konkrétních produktů na trh (Nsibande et al., 2025).

Analýza Share of Voice (SOV)

Díky atributu category, který scraper extrahuje z metadat Protextu, je možné provádět segmentovanou analýzu tržního podílu v médiích, v CI terminologii označovanou jako Share of Voice (SOV) (Nsibande et al., 2025). Objem publikací v daném sektoru přímo koreluje s viditelností značky a její schopností ovládnout téma (Špundová, 2024).

Analytik může filtrovat dataset například na kategorii “Finance” a vizualizovat rozložení mediálního prostoru. Subjekt s dominantním SOV v dané kategorii zpravidla určuje trendy, zatímco subjekty s nízkou aktivitou riskují ztrátu tržního povědomí (Pospíšil, 2011). Tato analýza rovněž odhaluje sektorové průniky – např. banka publikující v sekci IT naznačuje strategický důraz na fintech inovace.

Detekce signálů v čase

Časová řada, kterou dataset poskytuje skrze atribut date, je klíčová pro pochopení dynamiky konkurence a předvídání budoucích kroků (Early Warning Signals). CI není jen o statickém popisu, ale o proaktivním monitorování trendů a změn v čase.

Analýza časování komunikačních kampaní může odhalit.

- Cyklické vzorce: Pravidelnost v uvádění novinek, která umožňuje predikovat příští kroky konkurenta.

- Reakční schopnost: Měřením odstupu mezi tržní událostí a vydáním tiskové zprávylze hodnotit agilitu konkurence (Špundová, 2024).

Zpracovaná data tak slouží jako základ pro tvorbu actionable intelligence. Dané poznatky mohou umožnit provádět lepší strategické rozhodnutí a poskytují podniku udržitelnou konkurenční výhodu.

Závěr

Tato práce prokázala, že automatizovaný sběr dat je jednoduchým a efektivním, avšak právně komplexním nástrojem pro potřeby moderního Competitive Intelligence. Vyvinutý nástroj protext-scraper úspěšně demonstroval možnost získávání strukturovaných dat z platformy Protext.cz, přičemž klíčovým aspektem řešení byl striktní soulad s aktuálním legislativním rámcem. Implementace potvrdila, že technická efektivita sběru nemusí být v rozporu s etickými principy; využitím mechanismů polite scrapingu a oporou o zákonnou licenci pro vědecký výzkum (§ 39d autorského zákona) se podařilo legálně získat data i v prostředí, kde jsou komerční AI boti technicky omezováni prostřednictvím digitálního opt-outu.

V aplikační rovině práce identifikovala oficiální tiskové zprávy jako strategicky cenný zdroj primárních dat a definovala metodický rámec pro jejich využití. Získaný strukturovaný dataset vytváří nezbytný základ pro následnou aplikaci metod CI. Práce ukazuje cestu, jak transformovat nestrukturovaný text na měřitelné ukazatele, které analytikům v budoucnu umožní posun od pasivního monitoringu k proaktivní detekci tržních signálů a trendů.

Zdroje

- Apostle, J., & Schröder, C. (2024, říjen). First Significant EU Decision ConcerningData Mining and Dataset Creation to Train Artificial Intelligence.https://www.orrick.com/en/Insights/2024/10/Significant-EU-Decision-Concerning-Data-Mining-and-Dataset-Creation-to-Train-AI

- Beautiful Soup Documentation—Beautiful Soup 4.4.0 documentation. (b.r.).Získáno 16. listopad 2025, z https://beautiful-soup-4.readthedocs.io/en/latest/

- Clark, M. (2021, duben 15). How We Combat Scraping. Meta Newsroom.https://about.fb.com/news/2021/04/how-we-combat-scraping/

- Cursor. (b.r.). Cursor: The best way to code with AI. Cursor. Získáno 4. listopad2025, z https://cursor.com

- Čermák, J. (2025, 8). TDM výjimka a výhrada z ní ve světle trénování jazykovýchmodelů generativní umělé inteligence – část II. | pravoit.cz. pravoit.cz.https://pravoit.cz/novinka/tdm-vyjimka-a-vyhrada-z-ni-ve-svetle-trenovani-jazykovych-modelu-generativni-umele-inteligence-cast-ii

- Česká tisková kancelář. (b.r.-a). O službě Protext ČTK | Protext—PR služby ČTK.Protext. Získáno 3. listopad 2025, z https://protext.cz/protext-ctk.php

- Česká tisková kancelář. (b.r.-b). Úvodní strana | Protext—PR služby ČTK. Protext.Získáno 3. listopad 2025, z https://protext.cz/

- Fortinet, Inc. (2025). What Is Web Scraping? How Do Web Scrapers Work?Fortinet. https://www.fortinet.com/resources/cyberglossary/web-scraping

- Geiger, C., Frosio, G., & Bulayenko, O. (2018). The Exception for Text and DataMining (TDM) in the Proposed Directive on Copyright in the Digital SingleMarket—Legal Aspects (SSRN Scholarly Paper No. 3160586). Social ScienceResearch Network. https://doi.org/10.2139/ssrn.3160586

- Google. (b.r.). Google Scholar. Google Scholar. Získáno 30. listopad 2025, zhttps://scholar.google.com/

- Google. (2024). NotebookLM [Large language model]. In Google.https://notebooklm.google.com/

- Google. (2025). Gemini3 [Large language model]. https://gemini.google.com/app?hl=cs

- Hajba, G. L. (2018). Website Scraping with Python: Using BeautifulSoup andScrapy. Apress. https://doi.org/10.1007/978-1-4842-3925-4

- Kawase, T. (2023, prosinec 8). Co je to scraping? Vysvětlení právních problémůužitečné metody sběru dat, která přitahuje pozornost. MONOLITH LAW OFFICE |Tokyo, Japonsko. https://monolith.law/cs/general-corporate/scraping-datacollection-law

- lxml—Processing XML and HTML with Python. (b.r.). lxml. Získáno 2. prosinec2025, z https://lxml.de/

- Nsibande, O., Dinath, W., & Niemand, C. J. P. (2025). CI Practices to GainCompetitive Advantage through Social Media in the PR Industry. South AfricanJournal of Information Management, 27(1).https://doi.org/10.4102/sajim.v27i1.1996

- OpenAI. (2025). 5.1[Large language model]. In OpenAI. https://chatgpt.com/?model=gpt-4o

- Prozrová, A. (2020). Online PR jako součást komunikace Pražských náplavek[Diplomová práce, Vysoká škola ekonomická v Praze]. https://theses.cz/id/slhf19/

- Psf/requests. (2025). [Python]. PythonSoftware Foundation. https://github.com/psf/requests (Original work published 2011)

- Regulation (EU) 2016/679 of the European Parliament and of the Council of 27April 2016 on the Protection of Natural Persons with Regard to the Processing ofPersonal Data and on the Free Movement of Such Data, and Repealing Directive95/46/EC (General Data Protection Regulation) (Text with EEA Relevance), 119OJ L (2016). http://data.europa.eu/eli/reg/2016/679/oj

- Scrapy. (b.r.). Scrapy. Získáno 16. listopad 2025, z https://scrapy.org

- Selenium. (b.r.). Selenium. Získáno 16. listopad 2025, z https://www.selenium.dev/

- Špundová, K. (2024). Analýza efektivity PR vybraných filmových festivalů[Bakalářská práce, Vysoká škola ekonomická v Praze].https://theses.cz/id/f9j8bv/?lang=cs

- Tseriotis, A. M. (2025). Advanced Web Scraping in the Modern Web.

- Zákon č. 121/2000 Sb., Pub. L. No. 121/2000 Sb., Sbírka zákonů (2000).https://www.zakonyprolidi.cz/cs/2000-121