Úvod

Generativní umělá inteligence mění výrazným způsobem fungování trhů a firem na celém světě. Využívání těchto technologií je v dnešní době spíše povinnost, aby organizace obstáli v této konkurenční a rychle měnící se době. Na jednu stranu přináší při správném využití rychlost a efektivitu, kdy uživatelé dokáží vypracovávat úkoly ve zlomku času, kdy stejné zadání by jim ještě před několika lety trvalo o mnoho hodin déle. Na druhou stranu jsou firmy využívající těchto nástrojů vystaveny hrozbám, na které neví v mnoho případech jak reagovat.

Cílem této práce je analyzovat a propojit využití generativní umělé inteligence a promt engineeringu (PE) v kontextu competitive itelligence (CI) a zpravodajského cyklu. V práci jsou vymezeny teoretické poznatky z oblasti CI, GenAI a PE, ale i praktické ukázky jakým způsobem by měl analytik při využívání těchto nástrojů postupovat. Poukazuje na efektivitu a zrychlení práce při správném využití, ale odkazuje i na hrozby a rizika spojená s tímto tématem. Nakonec jsou uvedeny konkrétní příklady firem, které již tyto nástroje využívají.

1 Metodologie

Tato práce kombinuje kvalitativní metody a analytický přístup ke zjištění teoretických a praktických poznatků z oblasti generativní umělé inteligence, competitive intelligence a prompt engineeringu. Metodologie a rešerše poznatků kombinuje tradiční akademické výzkumné techniky s implementací moderních AI asistenčních nástrojů.

Práce se opírá o akademické články z renomovaných akademických databází. Základ literární rešerše a identifikace klíčových článku o těchto tématech byla provedena s využitím akademických vědeckých vyhledávačů, jako je Scopus, Google Scholar a Web of Science, které poskytli teoretický rámec díky široké škále akademických zdrojů. Časové vyhledávání nebylo nijak omezeno, ale vzhledem k povaze tématu byly preferovány aktuálnější články od roku 2023–2025.

Dále byla využita metoda tzv. Google Hackingu, což je metoda pokročilého Google vyhledávání. Tato metoda přinesla doplnění akademických zdrojů z akademických databází a umožnila užší a specifičtější rozsah vyhledávání.

K identifikaci základní osnovy, literární rešerši a strukturování myšlenek byly použity nástroje umělé inteligence. K rešerši zdrojů byly využity hlavně nástroje Perplexity.ai a Google Gemini, které identifikovali řadu akademických zdrojů relevantních pro tuto práci. Všechny články byly následně validovány a přístup byl umožněn skrz knihovnu Vysoké školy Ekonomické.

Další nástroj, který byl primárně použit k strukturování myšlenek, osnovy práce a vysvětlení komplexnějších témat byl ChatGPT od společnosti OpenAI.

V neposlední řadě byl použit NotebookLM od společnosti Google, který poskytnul prostředí k sumarizaci a správu znalostí všech identifikovaných zdrojů. Tento nástroj umožnil integraci mezi získanými materiály, generovanými poznatky a písemnou analýzou, a sloužil k identifikaci asistovaných shrnutí a návrhu citací.

Ke generování a kontrolu citací byl použit nástroj pro správu bibliografií a citací Zotero. Všechny použité zdroje byly nahrány a byly vygenerovány citace pomocí tohoto nástroje. Citace byly následně revidovány a manuálně upraveny o chybějící informace.

Ačkoliv nástroje umělé inteligence zvýšily efektivitu a rychlost při psaní této práce, etické standardy byly přísně dodržovány. Všechny citované práce jsou veřejně dohledatelné a ověřitelné v akademických databázích. V této práci nebyly použity žádné důvěrné nebo neveřejné údaje. Obsah vygenerovaný umělou inteligencí byl revidován tak, aby nedošlo k žádným nepřesnostem.

2 Competitive Intelligence v éře generativního AI

Competitive intelligence (CI) je obor, který jako většina v dnešní době podlého významným změnám z důvodu tlaku generativní umělé inteligence. Postupy a metody pro zjišťování informací o konkurenčním prostředí se mění každým dnem. Zrychlení zpravodajského cyklu významným způsobem nutí firmy rychleji reagovat na konkurenční prostředí a zachycovat slabé signály již v samotném zárodku. Jedině tak firmy zůstávají kompetitivní v dnešním rychle se měnícím prostředí.

CI neboli konkurenční zpravodajství je definováno mnoha způsoby, většina definic však klade důraz na systematický přístup ke shromažďování informací, etický přístup a dopad na strategické rozhodování. McGonagle & Vella (2002) definují CI jako proces, při kterém se využívají veřejné zdroje k získávání dat o konkurentech a prostředí, přičemž tato data jsou transformována na informace, které podporují obchodní rozhodnutí. Jedná se o etické, systematické a kreativní aplikace zpravodajské metodologie a klíčových metod, které integrují znalosti všech členů organizace. CI poskytuje informace o konkurentech, jejich strategii, cílech, silných a slabých stránkách a dává společnostem příležitost pochopit své postavení vůči konkurenci. Cílem firmy je získat konkurenční výhodu (Gémar, 2015). Klíčové aspektem je, že CI není jen o shromažďování dat a přeměňování na informace v požadovaném čase, ale firma musí zvolit správnou analýzu u různých druhů informací, a skrz tuto analýzu přidat informační hodnotu (Bartes, 2013).

2.1 Zpravodajský cyklus

Klíčovým aspektem celého CI je zpravodajský cyklus, který poskytuje systematický přístup ke shromažďování a transformaci surových dat do finálních informací (Bartes, 2013). CI rozděluje dva tradiční modely. Výběr závisí na komplexitě úkolů pro CI. Pro méně složité úlohy se využívá čtyřfázový model, který zahrnuje následující fáze (Bartes, 2013):

1) Plánování a řízení

2) Sběr dat

3) Analýza

4) Distribuce

V praxi se více využívá pětifázový model. Ten je vnímán jako lépe přizpůsobený pro řešení složitých úkolů současného podnikatelského prostředí. Vychází z analýzy devíti klíčových kroků zpravodajského cyklu a strukturuje analytické procesy do dvou navazujících etap, čímž umožňuje detailnější zpracování původních dat (Bartes, 2013):

1) Plánování a řízení cyklu

2) Shromažďování informací a provádění výzkumu (sběr dat)

3) Zpracování a ukládání informací (strukturování, hodnocení pravdivosti a úplnosti dat)

4) Zpravodajská analýza informací (tvorba přidané hodnoty – inteligence)

5) Distribuce zpravodajského produktu (tvorba finální zprávy a zpětné vazby)

2.2 Problémy a výzvy CI

Nástup AI a Big Data výrazně urychlil a zautomatizoval procesy konkurenčního zpravodajství. Úroveň jejich využití se však mezi firmami výrazně liší. Společnosti, které mají zavedený systematický a etický přístup k CI a aktivně začleňují umělou inteligenci, jsou podstatně efektivnější při sběru dat a dokážou si vytvářet udržitelnou konkurenční výhodu. Naopak organizace, jež přistupují ke CI nahodile a váhají s implementací AI, často výrazně zaostávají a provádějí své procesy méně efektivně než jejich konkurenti. CI se potýká se dvěma hlavními problémy, a to s výzvami související jak s povahou konkurenčního boje, tak s integrací nových technologií.

Klíčové problémy týkající se konkurenční prostředí jsou o složitosti úkolů a nejasnosti a komplikovanosti vztahů mezi konkurenty. S tím souvisí přetíženost informacemi, se kterými se organizace musí potýkat (Gémar, 2015). Narůstající počet dat způsobuje používání podvodných informací (dezinformací) ze strany konkurence, a tlačí firmy ke větší ochraně údajů a obchodních tajemství (Bartes, 2013). S trendem Big Data souvisí i nízká kvalita dat, což má dopad na kvalitu výstupů z analýz. To způsobuje, že firmy nemají dostatek kvalitních informací o konkurentech. Tradiční metody jako průzkum trhu, mohou být zastaralé a mohou vést ke krátkozrakosti při identifikaci konkurenčních vztahů (Yuan et al., 2023).

Druhou skupinou problému jsou výzvy spojené s AI a její adopcí. Jedním z problémů je nadměrné spoléhání firem na AI, což ztěžuje uživatelům smysluplné využití silných stránek a dohled nad jejich slabinami, což může vést ke zhoršení celkového výkonu (Passi & Vorvoreanu, n.d.). Organizace musí více vnímat AI nástroje jako soubor specializovaných inteligencí než jako jeden univerzální nástroj, který dokáže vše. Spoléhání na univerzalitu AI nástrojů limituje strategické rozhodování (AI hypertropie) (Campbell et al., 2025). Při používání nástrojů je však brát v potaz, že jednotlivá hodnocení jsou často nekonzistentní a zkreslená (biased) v rámci většího počtu AI aplikací(Doshi et al., 2025). Neposlední výzvou je nesoulad očekávaných a reálných schopností konkrétních GenAI inteligencí. Vývoj těchto inteligencí je nerovnoměrný, a vyžaduje přizpůsobení každého úkolu jednotlivým aplikacím dostupných v dané lokalitě. Firmy většinou riskují, že schopnosti těchto aplikací moc přecení, anebo ji podcení v oblastech, ve kterých už je silná. Například, text vygenerovaný AI je většinou z gramatického pohledu správně, ale ve většině případů nebere v potaz kulturní a emocionální nuance (Campbell et al., 2025).

3 Generativní AI a zpracování informací

Generativní umělá inteligence patří do skupiny technologií strojového učení, které generují nový obsah tím, že analyzují pravděpodobností vzorce v existujících datových sadách. Tento obsah může mít formu textu, obrázku, audia nebo videa (Campbell et al., 2025). Základním mechanismem těchto modelů je poziční kódování, které sleduje pořadí slov ve vstupu (query), a přiřazuje váhy důležitosti každému slovu v kontextu celkového vstupu. Tyto mechanismy jim umožňují zachytit dlouhé sémantické vztahy v textu (Lopez-Lira & Tang, 2025).

Základním mechanismem velkých jazykových modelů je tokenizace. Tento proces rozděluje text do menších, zpracovatelných jednotek zvaných tokeny. To jsou nejmenší elementární jednotky, které mohou představovat slova, části slov, symboly nebo dokonce jednotlivé znaky. Takto se zpracovávají jak data strukturovaná, což jsou data s jasným formátem a strukturou většinou ve formě sloupců a řádků, ale i nestrukturovaná, tedy data která nemají jasnou strukturu (například data generována sociálními médii, nebo obrázky a videa). Nestrukturovaná data jsou modely zpracována a transformována na malá písmena (tokeny), a následně lemmatizována, což je základní proces v rámci zpracování přirozeného jazyka (NLP), který převádí slova na jejich základní slovníkový tvar, tzv. lemma. Příklad takového procesu může být převedení slova běžel na běžet (Ju, 2024).

Další metodou NLP je stemming, který zpracovává a převádí nestrukturovaná data do strukturovaného formátu na základě odvozování kmenů slov (stems). Oproti lemmatizaci by tento proces převedl slovo bežel na běž. Lemmatizace je však více využívána kvůli její lepší interpretovatelnosti (Ju, 2024).

Obě metody spadají do širší fáze čištění dat, kdy je text převeden na malá písmena, odstraněna je interpunkce, číslice a stop slova, což jsou slova, která nemají analytickou hodnotu (např. „a“, „the“, „is“) (Ju, 2024).

Model následně funguje tak, že takto zpracovaný text kóduje do vícerozměrných vektorových reprezentací, kde jsou zachyceny kontextuální a sémantické vztahy. Sémantické vztahy odkazují na interpretaci a pochopení slov, frází, vět a vztahů mezi nimi (Chang et al., 2024). Kontextuální vazby určují, že sémantika je interpretována v rámci širšího okolí, což odkazuje na schopnost interpretovat enviromentální, časové a kulturní podněty za účelem generování relevantnějších a emočně citlivějších vstupů (Campbell et al., 2025).

K těmto vazbám se následně váže kontextové okno (context window), což je kritické omezení, které přímo ovlivňuje, jak efektivně dokáže jazykový model pracovat s kontextuálními a sémantickými vazbami (Huang et al., 2025). Zpracovaný text, kde jsou zachyceny všechny potřebné vztahy je použit k vygenerování výstupu modelu, který je generován autoregresivním způsobem, kdy model na základě naučených statistických vzorů predikuje následující tokeny na základě vstupů generovaného uživatelem. Model maximalizuje pravděpodobnost sekvence tokenů podmíněnou kontextem. Jazykové modely v poslední době prošly velkými inovacemi, kdy už nejsou schopné jen generovat výstup, ale také plánovat, rozhodovat a jednat s využitím nástrojů, paměti a uvažování (tzv. agentní AI) (Campbell et al., 2025).

Jak již bylo zmíněno na začátku, takovéto modely generují nový obsah na základě datových sad, na kterých jsou trénovány, a fungují na základě elementárních jednotek (tokenů). K tomu, aby modely dokázaly generovat relevantní obsah, musí být trénovány na obrovských korpusech textových dokumentů s miliony a miliardami tokenů. Například model GPT – 3 byl trénován na 300 miliardách tokenů a GPT – 4 na 13 bilionech tokenů (Brynjolfsson et al., 2025).

3.1 Využití generativního AI ve zpravodajské cyklu

Jazykové modely transformují zpravodajský cyklus tím, že zrychlují, zkvalitňují a automatizují klíčové fáze, jako je sběr, zpracování a analýza dat. Klíčové je, aby firmy přistupovaly k nástrojům generativního AI jako k dynamickému a vyvíjejícímu se spolupracovníkovi, namísto generického nástroje z důvodů zmíněných v kapitole 2.2. Obecně lze říci, že tyto modely dokáží generovat hodnotu skrze čtyři základní pilíře: překlad, shrnutí, klasifikace a amplifikace (zesílení) (Campbell et al., 2025).

A. Fáze plánování a řízení

V úvodní fázi zpravodajského cyklu dokážou jazykové modely rozkládat složité problémy dekompozicí komplexních úkolů na zvládnutelné pod úlohy, a navrhovat strategie a hypotézy formou Graph of Thoughts (GoT) a Tree-of-Thought (ToT) modelující informace jako komplexní graf nebo strom, což umožňuje zvažovat více možných řešení a strategií z různých úhlů pohledu, včetně pohledu dopředu (look ahead) a sebereflexe (self-evaluation) (Campbell et al., 2025).

B. Fáze sběru informací

V této fázi jsou jazykové modely nejvíce prospěšné tím, že umožňují přístup k aktuálním a rozsáhlým externím zdrojům, zejména pomocí augmentace vyhledávání (RAG). Tato technika rozšiřuje jazykové modely o externí znalostní databáze připojené uživatelem, což překonává omezení jazykových modelů (např. halucinace, vyhledávání zastaralých informací) tím, že vyhledávají relevantní dokumenty a zahrnují je do vstupu (promptu) (Y. Gao et al., 2024).

C. Fáze zpracování a ukládání informací

Následně je nutné shromážděná data očistit, strukturovat a zpracovat pro analýzu. Jazykové modely zde uplatňují pravidla popsané v kapitole 3. o zpracování textu. Všechny dostupné informace model segmentuje (tzv. chunking) do menších bloků, které jsou ukládány do vektorových databází. Tento proces je klíčový pro větší relevanci výstupu modelu (Huang et al., 2025). Následně jsou všechny dostupné bloky přeřazeny podle relevantnosti. Ty nejvíce relevantnější bloky se objeví na začátku a model omezí celkový počet bloků pro následné zpracování. Nakonec vybrané texty zkrátí na takovou délku, aby se předešlo informačnímu přetížení a problému „Lost in the middle“ (tendence jazykového modelu ignorovat informace uprostřed textu) (Y. Gao et al., 2024).

D. Fáze analýzy

Díky schopnostem uvažování, predikce a klasifikace přináší jazykové modely největší přidanou hodnotu ve fázi analýzy. Modely dokážou efektivně uvažovat nad problémy a navrhovat řešení. Jsou schopné uvažovat nad kroky vyhodnocování problémů a predikovat finanční dopady jednotlivých návrhů. Modely jako GPT – 4 dokážou přesně posoudit ekonomické dopady zpráv a tím predikovat výnosy či ztráty. Díky vyšší pokročilosti moderních modelů je možné analyzovat a interpretovat zprávy vyžadující hlubší analytické uvažování (např. oznámení příjmů nebo změny ratingu akcií) (Lopez-Lira & Tang, 2025).

E. Fáze distribuce

V poslední fázi zpravodajského cyklu se uplatňují jazykové modely při sumarizaci informací a hodnocení kvality výstupů. Generují plynulý, koherentní a relevantní obsah, jako jsou články, zprávy nebo marketingové kopie. Výsledky překládá a poskytuje přirozenější překlady než starší nástroje. Klíčová je interakce s jazykovým modelem, kdy dokáže upravit výstup do požadovaného formátu nebo systému na základě zpětné vazby od uživatele (Chen et al., 2025). Na základě metrik automaticky hodnotí kvalitu výstupu (např. plynulost, přesnost, novost a relevance) (Lopez-Lira & Tang, 2025).

4 Prompt engineering (PE)

Podle Chen et al., (2025) je prompt engineering systematický proces navrhování a optimalizace vstupních pokynů (tzv. promptů) pro velké jazykové modely (LLMs). Jeho hlavním cílem je maximalizovat užitečnost, přesnost, relevanci, koherenci a použitelnost generovaného výstupu. Umožňuje využít plný potenciál LLMs tím, že usměrňuje jejich chování a zvyšuje jejich účinnost. Dobře navržený prompt je klíčový ke generování relevantního obsahu bez chyb, jako jsou strojové halucinace.

Metodologie rozlišuje dvě základní skupiny technik vedení modelu k přesnější a strukturovanějším odpovědím.

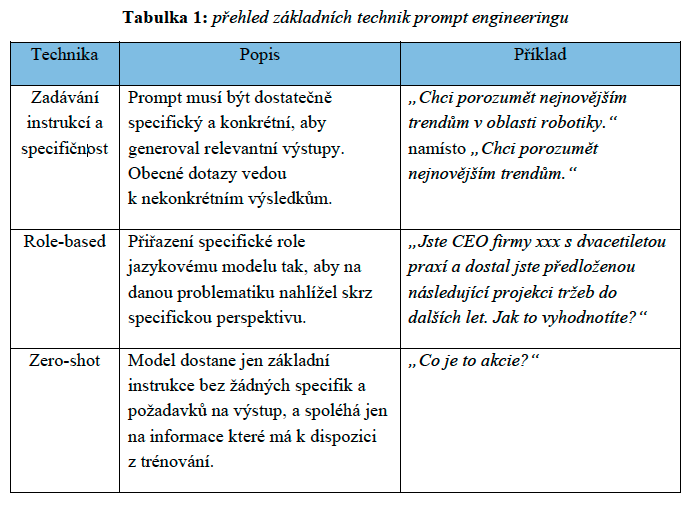

4.1 Základní (foundational) techniky

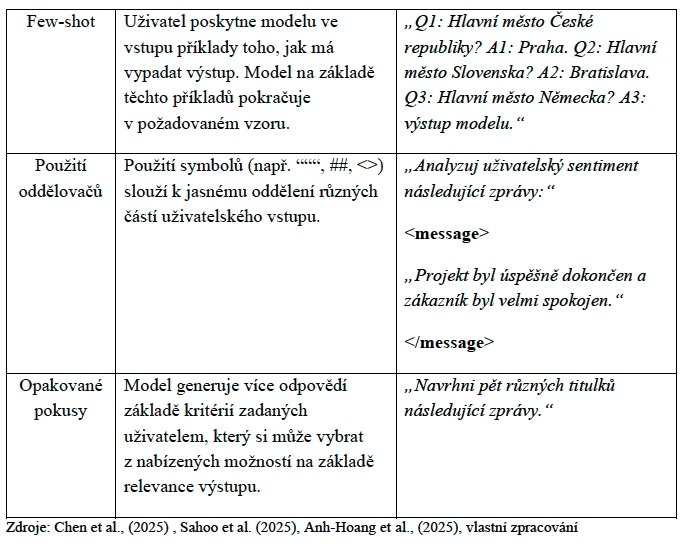

Základní techniky jsou oproti těm pokročilejším jednodušší a uchopitelnější pro netechnického uživatele. Mají jasnou strukturu a specifičnost, aby model zúžil prostor odpovědí (Chen et al., 2025). V tabulce 1 je přehled o základních technikách PE včetně příkladů.

4.2 Pokročilé (advanced) techniky

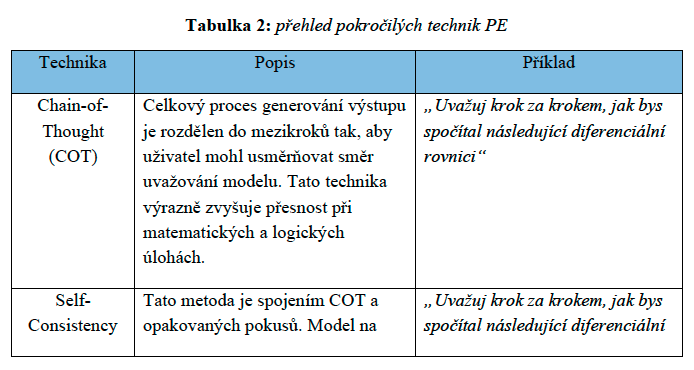

Tyto techniky jsou navrženy k řešení komplexnějších úkolů s cílem zajistit co nejvíce relevantní výstup bez halucinací (Chen et al., 2025). V tabulce 2 je přehled pokročilých technik a jejich ilustrace na konkrétních příkladech.

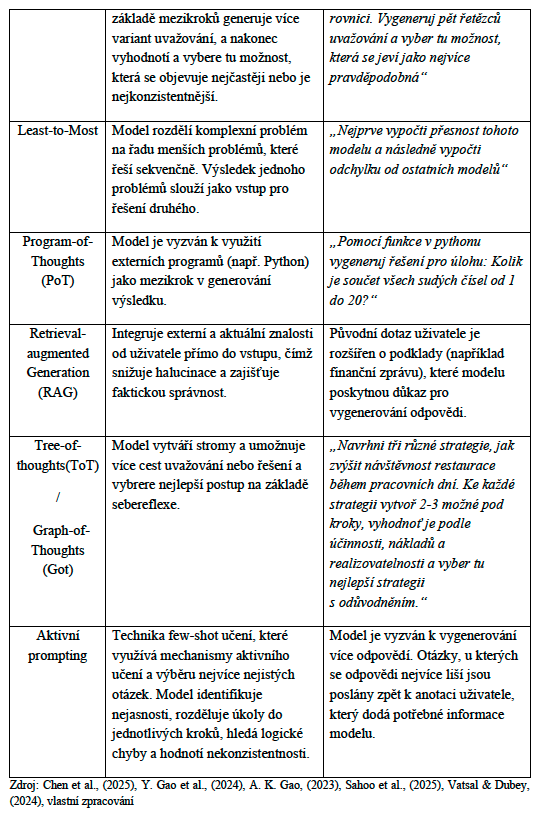

Pokročilé techniky PE dosahují daleko vyšší relevantnosti výstupu než standartní prompting. V následující tabulce můžeme vidět porovnání přesnosti techniky COT se standartními prompt technikami.

Je důležité poznamenat, že technika CoT pozitivně neovlivňuje výkon, dokud není použita s modelem dostatečné velikosti (Wei et al., 2023).

Technika PoT, které deleguje výpočty programovacímu jazyku python dosahuje průměrnému zlepšení výkonu o 12 % oproti technice CoT v matematických a logických úlohách (Vatsal & Dubey, 2024).

Na základě daných informací je očividné, že pro strategické řízení firmy a zrychlení zpravodajského cyklu je klíčové použití správné metody PE k dosáhnutí co nejvíce relevantních informací bez halucinací. Dále je klíčové přizpůsobit výběr techniky k povaze úkolu. K úkolům matematické nebo logické povahy bude vhodnější technika PoT, avšak k úkolům kreativnější charakteru a generování nápadů bude analytikovi spíše vyhovovat CoT, ToT nebo GoT.

5 Využití PE a generativního AI v CI

Jak již bylo v textu zmíněno, nástroje generativního AI a PE jsou klíčové ke zvýšení efektivity a rychlosti práce CI analytika v průběhu celkového zpravodajského cyklu. Pro účel competitive intelligence se nejvíce využívají k řešení následujících analytických úkolů.

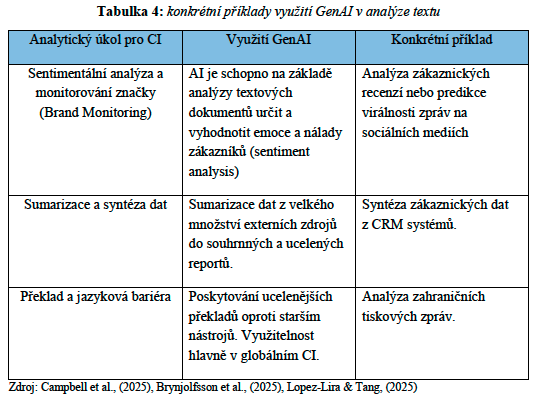

- Lingvistická inteligence

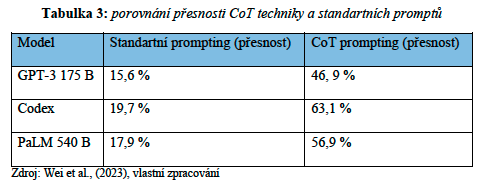

Tato inteligence zahrnuje práci s textem, od shromáždění, zpracování až po tvorbu obsahu a klíčových analýz (Campbell et al., 2025). Následující tabulka sumarizuje klíčové analytické úkoly a konkrétní příklady pro CI.

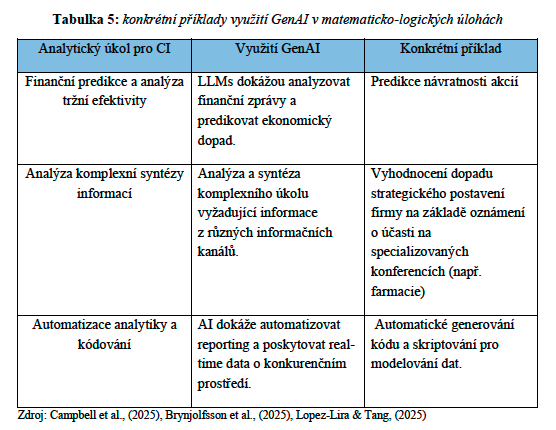

2. Logicko-matematická inteligence

Tato analýza se zaměřuje na řešení matematických a logických problémů, predikativní analýzu a rozpoznávání vzorů (Campbell et al., 2025). Tabulka 5 sumarizuje konkrétní příklady využití.

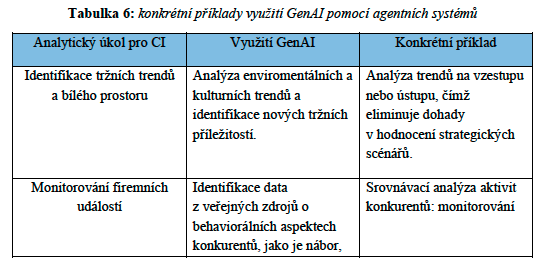

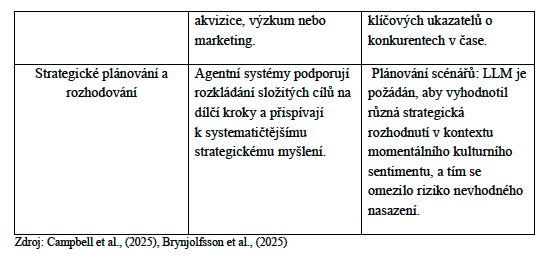

3. Kontextuální a agentní inteligence

Tyto typy inteligence se stále rozvíjejí, avšak už nyní představují zásadní prvek pro úspěšné zvládání dynamických a strategických úloh. V následující tabulce je výčet těch nejdůležitějších úkolů pro CI.

Již mnoho firem úspěšně implementovalo generativní AI do jejich zpravodajského cyklu. Například francouzský maloobchodní řetězec Carrefour implementoval generativního asistenta svým zaměstnancům, který poskytuje real-time přehled o produktovém positioningu konkurence a doporučení úpravy nabídky během interakce se zákazníkem. Dalšími firmami, které implementovali nepřetržitý monitoring konkurence jsou Walmart a Amazon. Například Walmart predikuje potřeby zásob tím, že kombinuje data o chování konkurence (cenové změny, promo akce) a tím predikuje poptávku po produktech. (Banafont, n.d.). Dalším příkladem je AI výzkumná platforma Northern Light SinglePoint, která centralizovala tisíce zdrojů (vědecké články, regulační dokumenty, analytické zprávy) do jednoho AI-portálu pro farmaceutické firmy. Tato platforma firmám ušetří pět milionů dolarů ročně (Northern Light, 2025).

Dané příklady ilustrují důležitost implementování generativních AI nástrojů do zpravodajského cyklu a ukazují, že firmy, které úspěšně implementují tyto nástroje získávají konkurenční výhodu.

6 Rizika, etika a limity

Generativní AI a PE s sebou nesou řadu významných rizik a limitací, které můžou významným způsobem ohrozit kvalitu výstupu.

Nejzásadnějším je již několikrát zmíněná halucinace a faktické nepřesnosti. Halucinace odkazuje na případy, kdy model generuje zdánlivě uvěřitelný, ale fakticky nekonzistentní nebo absurdní obsah, který je nepodložen. To může být ve formě malých nepřesností, ale i zcela imaginárního obsahu (Sahoo et al., 2024). Halucinace je jedna z kritických příčin, proč LLMs nelze používat na úkoly vyžadující vysokou faktickou přesnost (Xi et al., 2023). Tyto nepřesnosti vytvářejí riziko dezinformací, snižují důvěru a vedou k mezerám v odpovědnosti za daný výstup (Anh-Hoang et al., 2025). Příčin halucinací je několik. Data pro trénování mohla být zkreslena, nebo model může mít omezený přístup k aktuálním informacím nebo špatně pochopil kontext vstupu (Sahoo et al., 2024).

Dalším rizikem je zaujatost a neobjektivita modelů (bias), které vznikají z důvodu nevyváženosti tréninkových dat, ve který je obsažen škodlivý obsah a sociální zaujatost, což způsobuje etická a sociální rizika. LLMs šíří a potenciálně zvětšují tento obsah (např. stereotypy vůči určité demografické identitě, rase, pohlaví nebo ideologii) (Chang et al., 2024).

Asi nejdůležitějším rizikem z pohledu CI jsou rizika spojená s kybernetickou bezpečností a PE, který ačkoli zvyšuje produktivitu, otevírá nové vektory útoků, které mohou ohrozit integritu a důvěryhodnost zpravodajských dat. Pomocí promtu lze odhalit vlastnická a interní data, nebo jiný důvěryhodný materiál určený jen pro interní použití. Toto riziko je hmatatelné a vyžaduje systematické řízení firemních dat (Campbell et al., 2025). Už několik firem doplatilo na to, že nahráli senzitivní data do LLMs jako je Chatgpt. Asi nejznámějším případem je celosvětová firma Samsung, kdy jeden ze zaměstnanců nahrál interní kód do tohoto chatbotu a tím narušil integritu vnitropodnikových dat (Siladitya, 2023). Tím, že modely všechny vstupy ukládají a následně se na nich trénují, jsou data navždy uložena na serverech mimo kontrolu společnosti. Firmy se musí chovat zodpovědně a eticky k vnitropodnikovým datům a informacích o svých zákaznících tak, aby nedošlo k narušení soukromí, což s sebou nese jak finanční, tak i reputační riziko.

Dalším rizikem jsou tzv. adversární útoky, kdy na základě cíleně škodlivého promtu je model manipulován tak, aby uživatelům generoval škodlivé výstupy (Campbell et al., 2025)

Závěr

Cílem práce bylo analyzovat využití generativní umělé inteligence a promt engineeringu v kontextu competitive itelligence a zpravodajského cyklu. Práce popisuje jak teoretické poznatky z oblasti CI, generativního AI a prompt engineeringu, ale zkoumá i praktické techniky, metody využití a použitelnost pro práci CI analytika.

Implementace generativního AI je klíčové pro strategický rozvoj a kompetitivnost firmy. Využití nástrojů GenAI zvyšuje produktivitu, rychlost a efektivitu v každé fázi zpravodajského cyklu, od plánování přes sběr a analýzu dat, až po distribuci zpravodajského produktu. Klíčové je výběr správného nástroje, který vyhovuje povaze daného úkolu. Analytik musí zvolit správnou metodu dotazování, která povede k relevantnímu výstupu bez halucinací. Práce dále vyzdvihuje etický a kritický přístup k využívání těchto nástrojů. Uživatel musí strukturovat své dotazy v soulady s nejlepšími postupy PE (jako RAG augmentace nebo ToT přístup) s přihlédnutím na senzitivu interních dat jako jsou uživatelské informace jejich zákazníků, aby nedošlo k narušení těchto dat a uložení na veřejný server. To s sebou nese jak finanční, tak i reputační riziko.

Práce ilustruje využití GenAI ve zpravodajském cyklu na reálných příkladech firem jako je Walmart nebo Carrefour, kteří již využívají real-time analytiku informací o konkurentech ke zlepšení své strategické pozice na trhu.

Analytik by neměl tyto nástroje brát jako všemocný a univerzální nástroj který dokáže vše. Měl by využívat sadu těchto nástrojů a brát je spíše jako asistenta pro zrychlení a vylepšení svého výstupu práce.

Zdroje

Anh-Hoang, D., Tran, V., & Nguyen, L.-M. (2025a). Survey and analysis of hallucinations in large language models: Attribution to prompting strategies or model behavior. Frontiers in Artificial Intelligence, 8, 1622292. https://doi.org/10.3389/frai.2025.1622292

Anh-Hoang, D., Tran, V., & Nguyen, L.-M. (2025b). Survey and analysis of hallucinations in large language models: Attribution to prompting strategies or model behavior. Frontiers in Artificial Intelligence, 8, 1622292. https://doi.org/10.3389/frai.2025.1622292

Banafont, A. (n.d.). How Generative AI is redefining competitive analysis—Flipflow Blog. Retrieved November 29, 2025, from https://www.flipflow.io/en/blog-en/generative-ai-redefining-competitive-analysis/

Bartes, F. (2013). Five-phase model of the intelligence cycle of Competitive Intelligence. Acta Universitatis Agriculturae et Silviculturae Mendelianae Brunensis, 61(2), 283–288. https://doi.org/10.11118/actaun201361020283

Brynjolfsson, E., Li, D., & Raymond, L. (2025). Generative AI at Work. The Quarterly Journal of Economics, 140(2), 889–942. https://doi.org/10.1093/qje/qjae044

Campbell, C., Sands, S., Whittaker, L., & Mavrommatis, A. (2025). The AI intelligence playbook: Decoding GenAI capabilities for strategic advantage. Business Horizons, S0007681325001405. https://doi.org/10.1016/j.bushor.2025.08.004

Chang, Y., Wang, X., Wang, J., Wu, Y., Yang, L., Zhu, K., Chen, H., Yi, X., Wang, C., Wang, Y., Ye, W., Zhang, Y., Chang, Y., Yu, P. S., Yang, Q., & Xie, X. (2024). A Survey on Evaluation of Large Language Models. ACM Transactions on Intelligent Systems and Technology, 15(3), 1–45. https://doi.org/10.1145/3641289

Chen, B., Zhang, Z., Langrené, N., & Zhu, S. (2025). Unleashing the potential of prompt engineering for large language models. Patterns, 6(6), 101260. https://doi.org/10.1016/j.patter.2025.101260

Doshi, A. R., Bell, J. J., Mirzayev, E., & Vanneste, B. S. (2025). Generative artificial intelligence and evaluating strategic decisions. Strategic Management Journal, 46(3), 583–610. https://doi.org/10.1002/smj.3677

Gao, A. K. (2023). Prompt Engineering for Large Language Models.

Gao, Y., Xiong, Y., Gao, X., Jia, K., Pan, J., Bi, Y., Dai, Y., Sun, J., Wang, M., & Wang, H. (2024). Retrieval-Augmented Generation for Large Language Models: A Survey (arXiv:2312.10997). arXiv. https://doi.org/10.48550/arXiv.2312.10997

Gémar, G. (2015). Text mining social media for competitive analysis. Management Studies.

Huang, L., Yu, W., Ma, W., Zhong, W., Feng, Z., Wang, H., Chen, Q., Peng, W., Feng, X., Qin, B., & Liu, T. (2025). A Survey on Hallucination in Large Language Models: Principles, Taxonomy, Challenges, and Open Questions. ACM Transactions on Information Systems, 43(2), 1–55. https://doi.org/10.1145/3703155

Ju, X. (2024). A social media competitive intelligence framework for brand topic identification and customer engagement prediction. PLOS ONE, 19(11), e0313191. https://doi.org/10.1371/journal.pone.0313191

Lopez-Lira, A., & Tang, Y. (2025). Can ChatGPT Forecast Stock Price Movements? Return Predictability and Large Language Models (arXiv:2304.07619). arXiv. https://doi.org/10.48550/arXiv.2304.07619

McGonagle, J. J., & Vella, C. M. (2002). Bottom Line Competitive Intelligence. Bloomsbury Academic.

Northern Light. (2025, November 12). How a Fortune 50 Pharma Company Saved $5M+ and Scaled Strategic Intelligence with SinglePointTM. https://www.northernlight.com/blog/how-a-fortune-50-pharma-company-saved-5m-and-scaled-strategic-intelligence-with-singlepoint-tm?utm_source=chatgpt.com

Passi, S., & Vorvoreanu, M. (n.d.). Overreliance on AI Literature Review.

Sahoo, P., Meharia, P., Ghosh, A., Saha, S., Jain, V., & Chadha, A. (2024). A Comprehensive Survey of Hallucination in Large Language, Image, Video and Audio Foundation Models. Findings of the Association for Computational Linguistics: EMNLP 2024, 11709–11724. https://doi.org/10.18653/v1/2024.findings-emnlp.685

Sahoo, P., Singh, A. K., Saha, S., Jain, V., Mondal, S., & Chadha, A. (2025). A Systematic Survey of Prompt Engineering in Large Language Models: Techniques and Applications (arXiv:2402.07927). arXiv. https://doi.org/10.48550/arXiv.2402.07927

Siladitya, R. (2023, May 2). Samsung Bans ChatGPT Among Employees After Sensitive Code Leak. https://www.forbes.com/sites/siladityaray/2023/05/02/samsung-bans-chatgpt-and-other-chatbots-for-employees-after-sensitive-code-leak/

Vatsal, S., & Dubey, H. (2024). A Survey of Prompt Engineering Methods in Large Language Models for Different NLP Tasks (arXiv:2407.12994). arXiv. https://doi.org/10.48550/arXiv.2407.12994

Wei, J., Wang, X., Schuurmans, D., Bosma, M., Ichter, B., Xia, F., Chi, E., Le, Q., & Zhou, D. (2023). Chain-of-Thought Prompting Elicits Reasoning in Large Language Models (arXiv:2201.11903). arXiv. https://doi.org/10.48550/arXiv.2201.11903

Xi, Z., Chen, W., Guo, X., He, W., Ding, Y., Hong, B., Zhang, M., Wang, J., Jin, S., Zhou, E., Zheng, R., Fan, X., Wang, X., Xiong, L., Zhou, Y., Wang, W., Jiang, C., Zou, Y., Liu, X., … Gui, T. (2023). The Rise and Potential of Large Language Model Based Agents: A Survey (arXiv:2309.07864). arXiv. https://doi.org/10.48550/arXiv.2309.07864

Yuan, H., Deng, W., Ma, B., & Qian, Y. (2023). Monitoring Events of Market Competitors: A Text Mining Method for Analyzing Massive Firm-Generated Social Media. Journal of Theoretical and Applied Electronic Commerce Research, 18(2), 908–927. https://doi.org/10.3390/jtaer18020047